UnityでForwardのライトに対応したLambert反射モデルのシェーダを作成する

はじめに

以前に作ったUnityのシェーダはUnityのライトには反応せず 常にプロパティで与えた方向の光が当たるものでした。 このままではシーンに配置されたライトには反応してくれません。 そこで今回はUnityのForwardのライトに対応したLambertシェーダを作ってみます。 適宜Unityで用意されたマクロを利用しますが、そのマクロの中身についても見ていきます。

マクロについてはドキュメント化されていないものも多く、推測が多数含まれています。 また、私自身の知識が足りていないことによる誤りも多数含まれていると思われます。 この記事を参考にする場合は自己責任でお願いします。

- Unityのバージョン: 2018.3.0b5

Forwardのライティングパス

UnityのForwardのライティングパスについては次のページが詳しいです。

公式のドキュメントは次のページです。

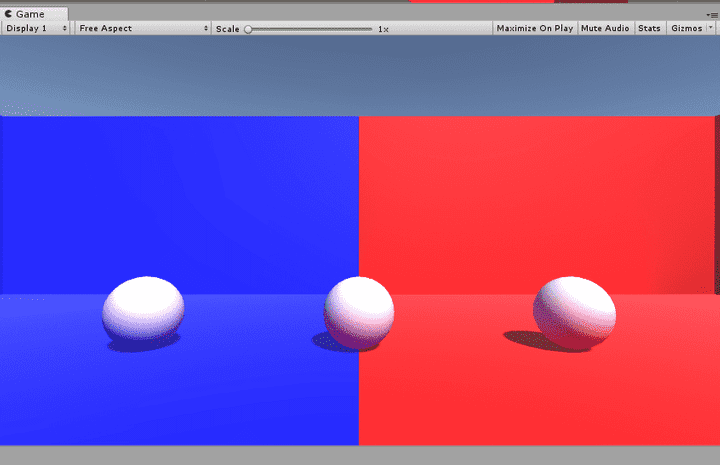

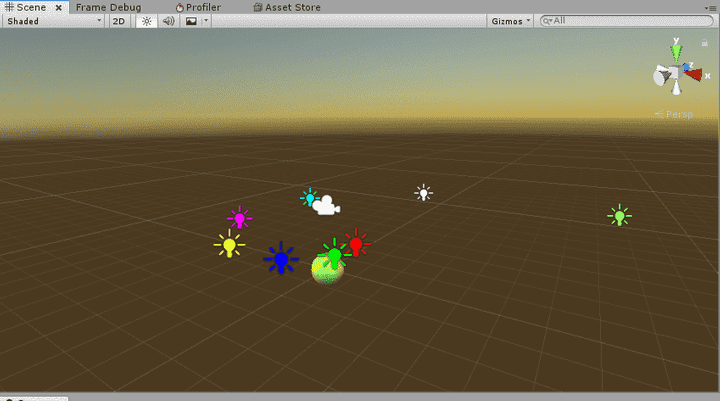

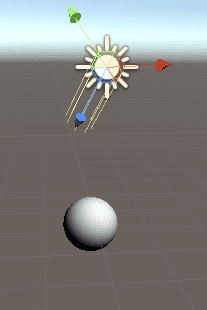

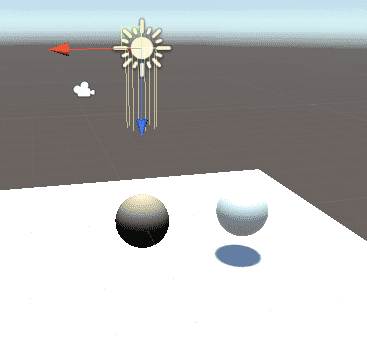

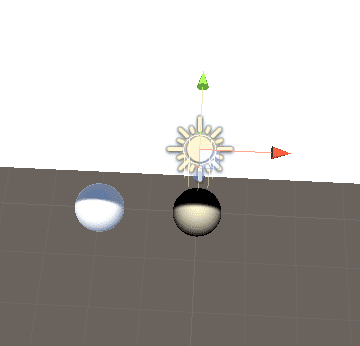

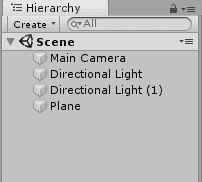

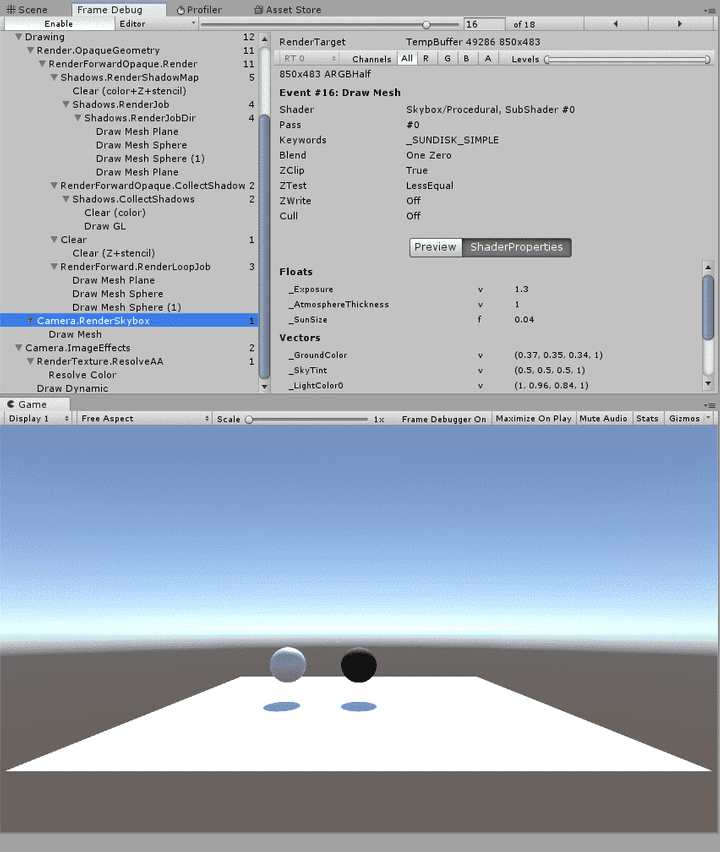

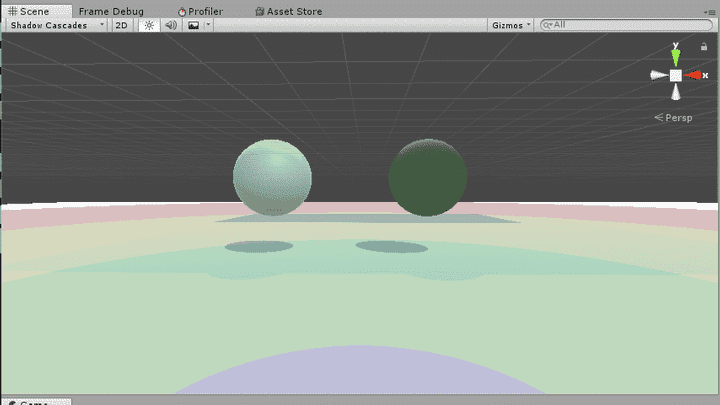

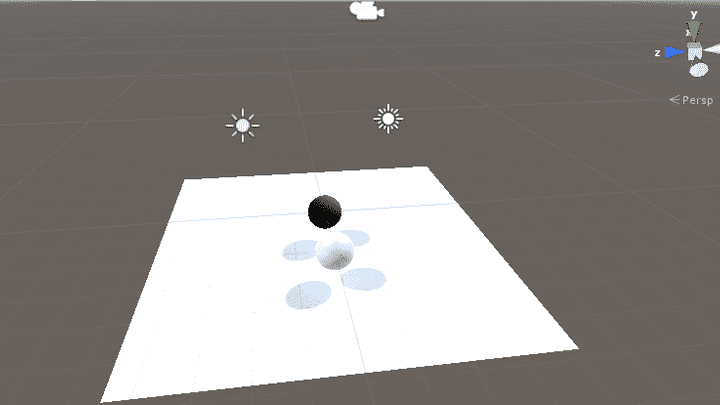

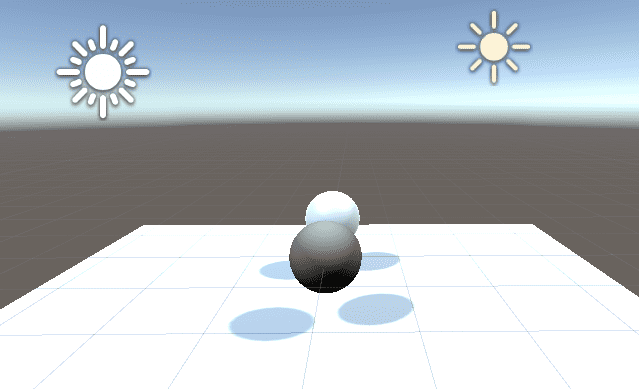

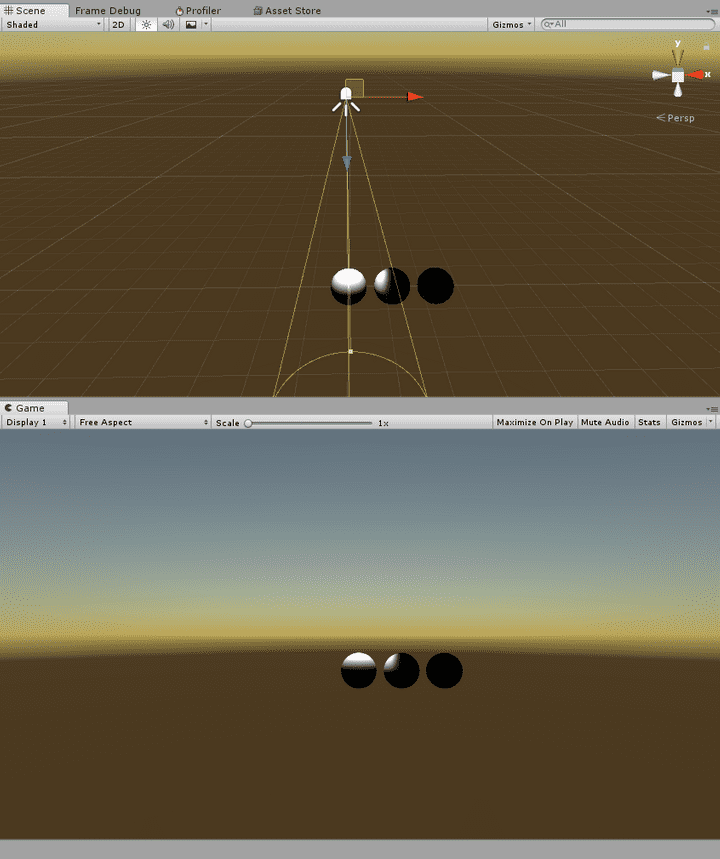

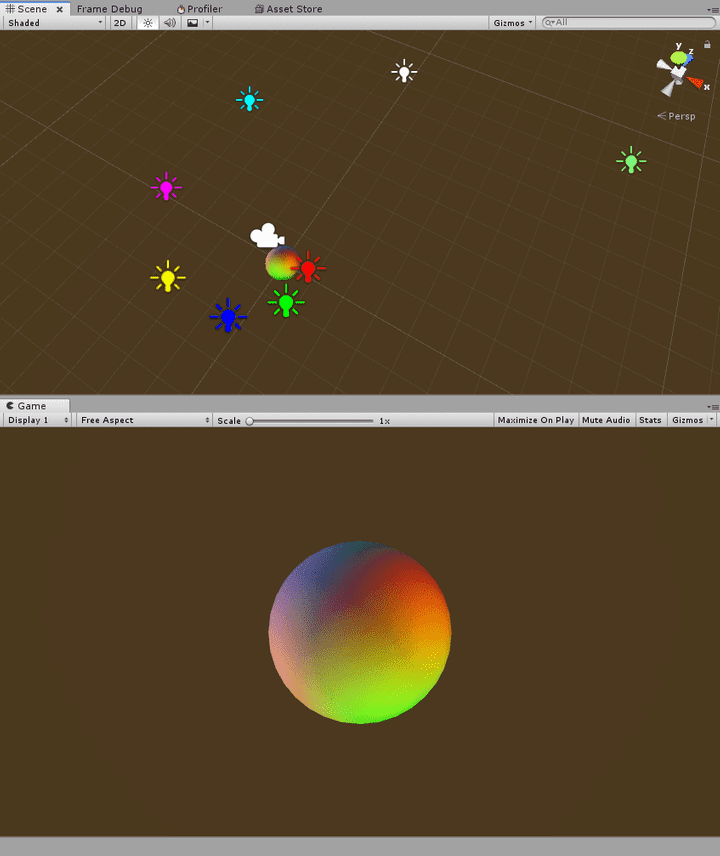

実際に次のようなポイントライトを8つおいたシーンを作成して試してみます。 球はライトのある平面より少し下に配置しています。 球体のマテリアルはStandard Shaderです。

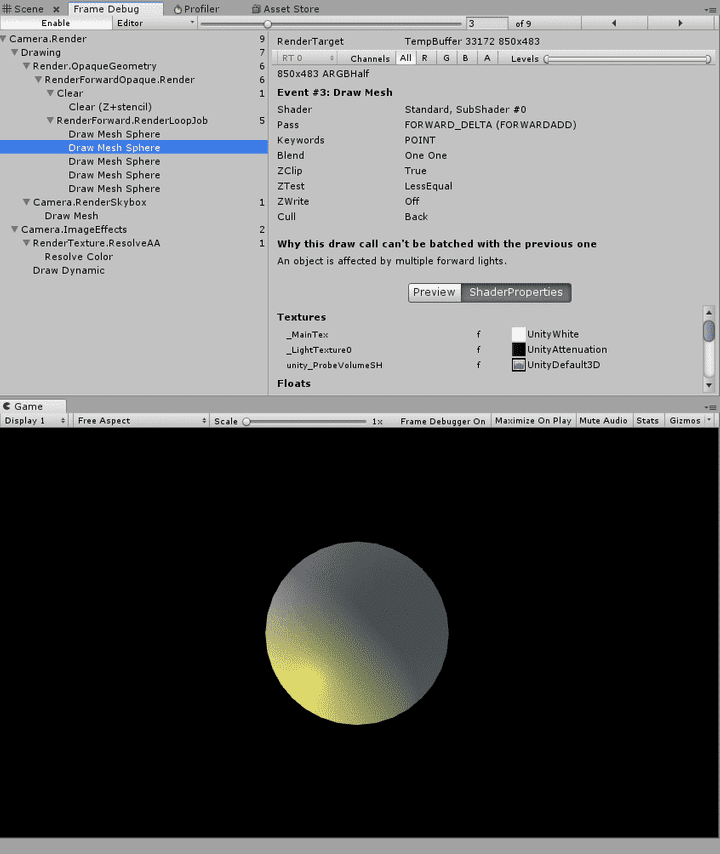

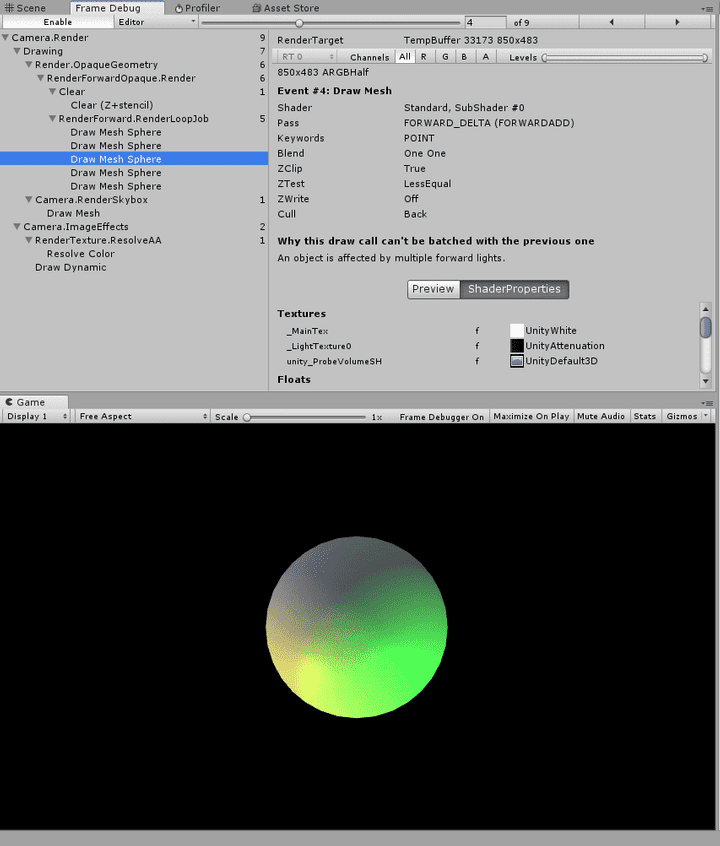

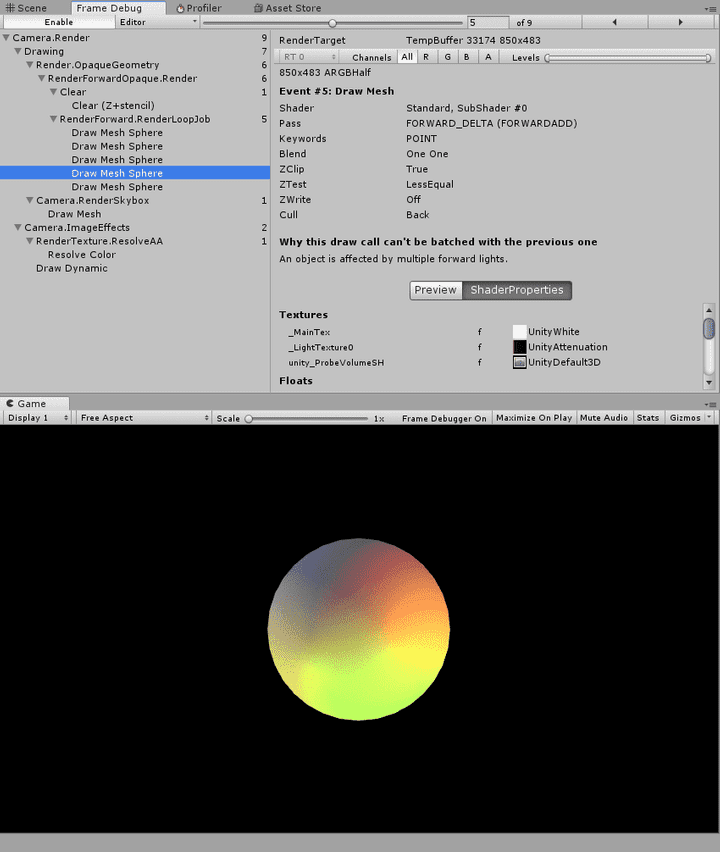

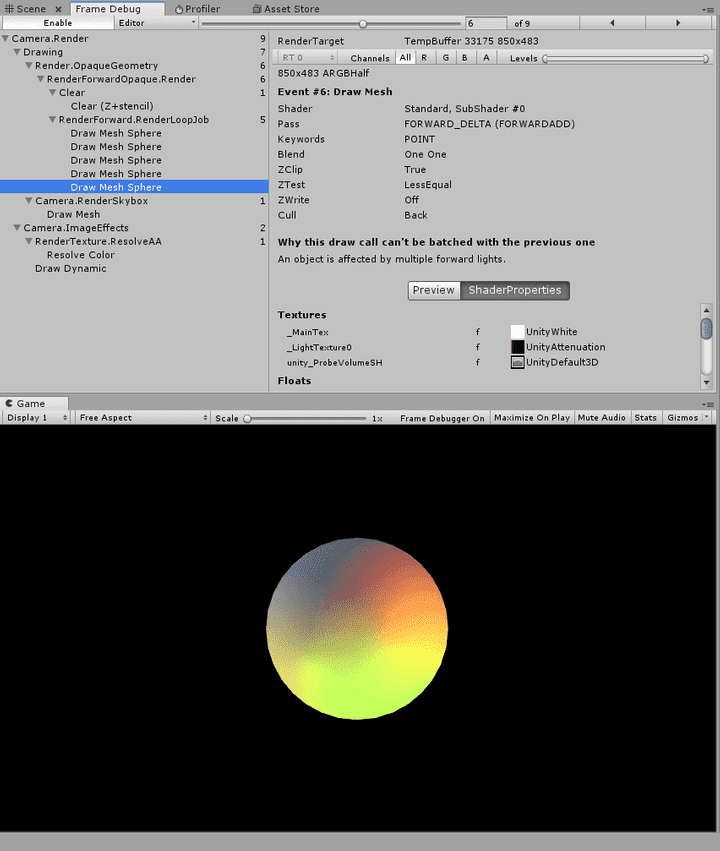

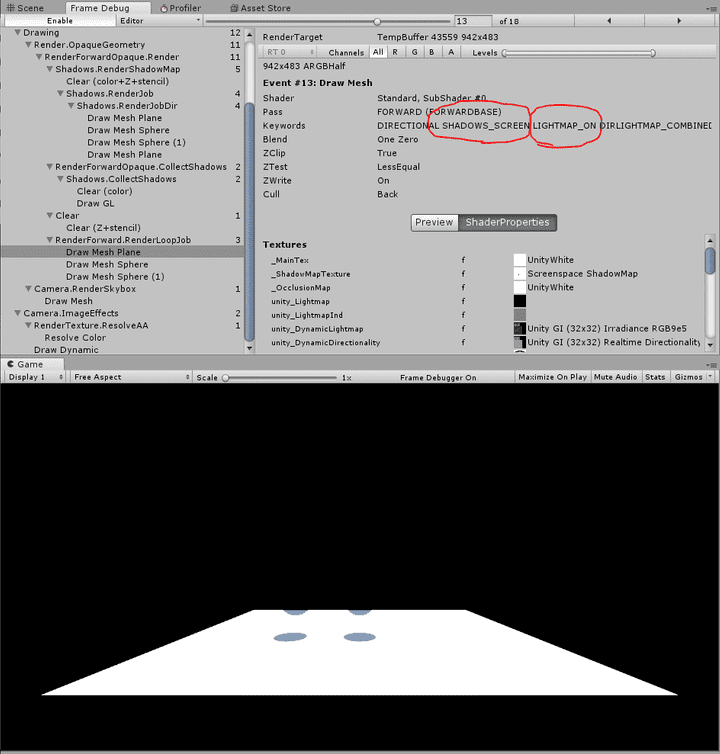

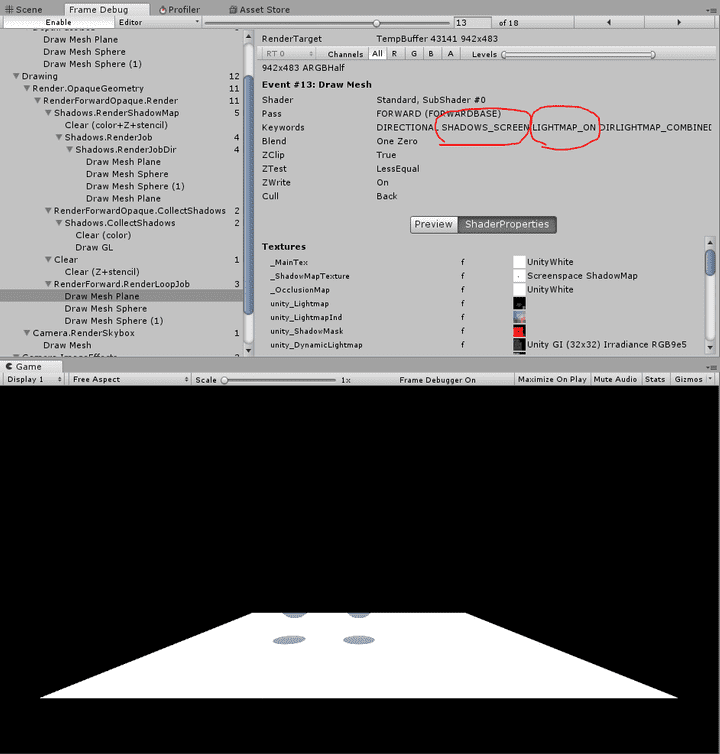

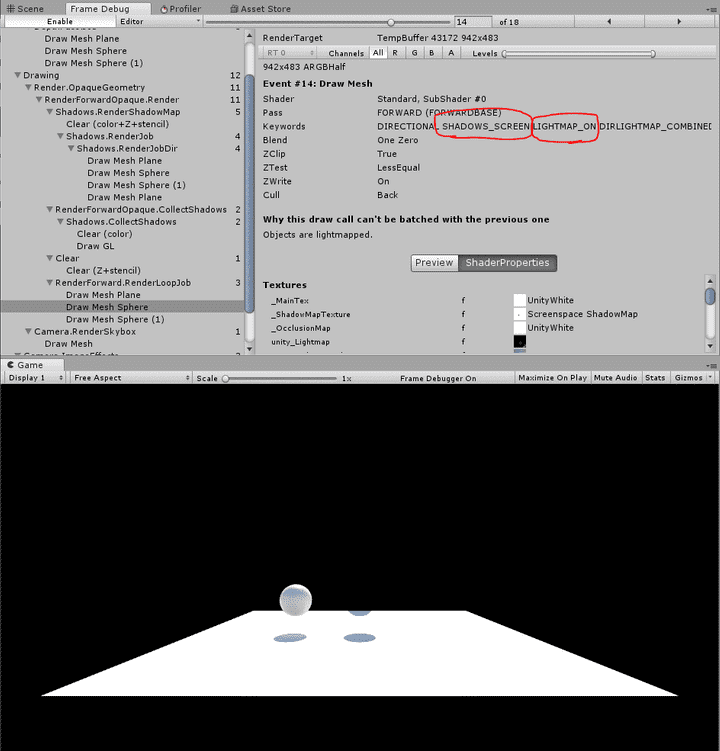

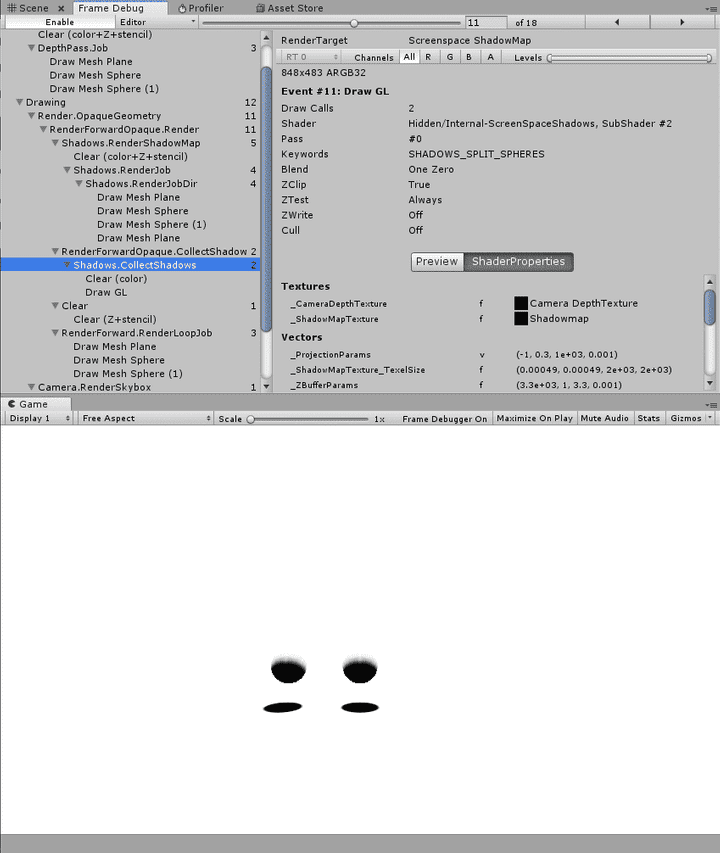

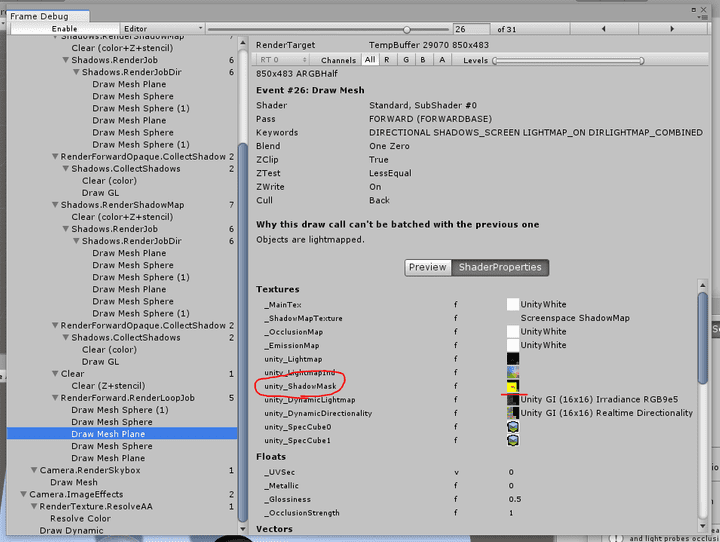

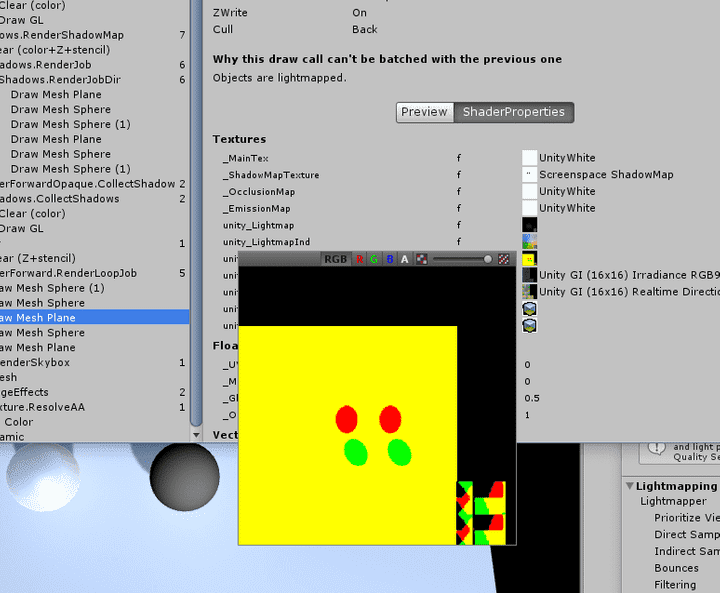

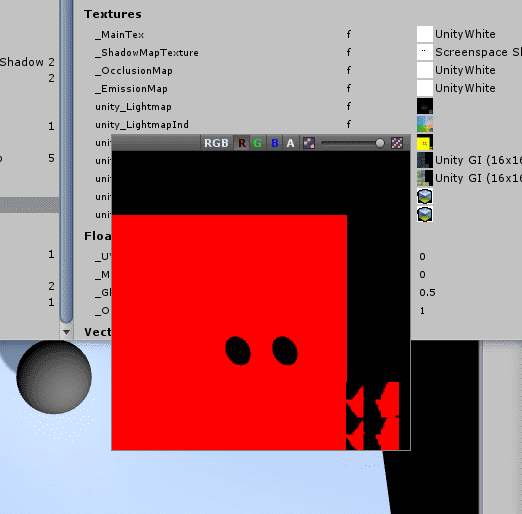

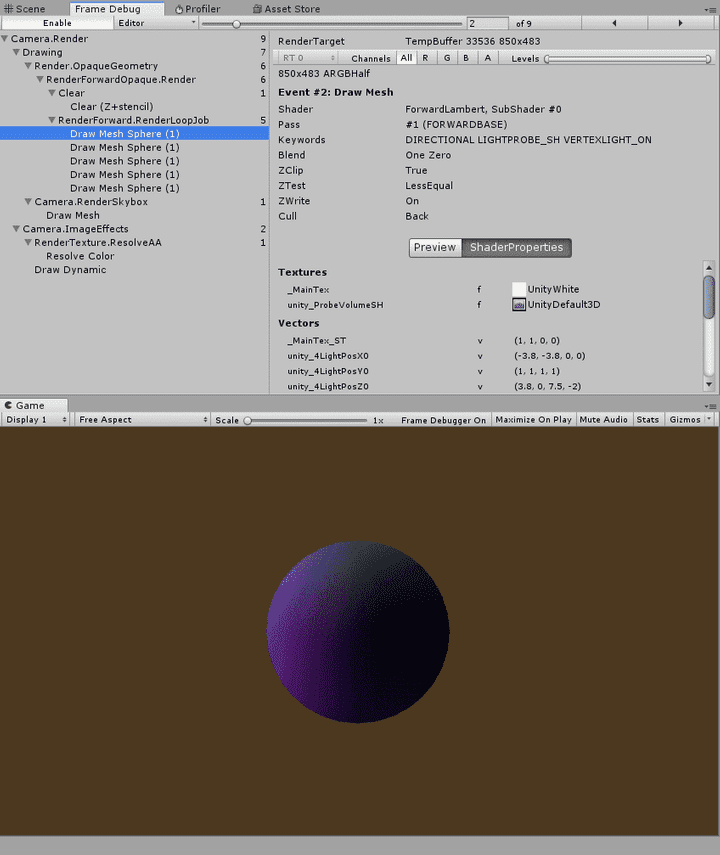

フレームデバッガで確認してみると次のようになります。

1パス目のベースパスが暗いですが、これは平行光源が置かれていないシーンのためです。 どうやらベースパスでは平行光源しか扱わないようです。 この平行光源のないシーンでは加算パスが計4回実行されていました。

平行光源1つに対応したシェーダを書く

まずは平行光源1つに対応するところから始めてみます。

Shader "ForwardLambert"

{

Properties

{

_MainTex ("Texture", 2D) = "white" {}

}

SubShader

{

Pass

{

Tags { "LightMode"="ForwardBase"}

CGPROGRAM

#pragma vertex vert

#pragma fragment frag

#include "UnityCG.cginc"

#include "Lighting.cginc"

struct appdata

{

float4 vertex : POSITION;

float3 normal : NORMAL;

float2 uv : TEXCOORD0;

};

struct v2f

{

float4 vertex : SV_POSITION;

float2 uv : TEXCOORD0;

float3 worldNormal : TEXCOORD1;

};

sampler2D _MainTex;

float4 _MainTex_ST;

void vert (in appdata v, out v2f o)

{

o.vertex = UnityObjectToClipPos(v.vertex);

o.worldNormal = UnityObjectToWorldNormal(v.normal);

o.uv = TRANSFORM_TEX(v.uv, _MainTex);

}

void frag (in v2f i, out fixed4 col : SV_Target)

{

float3 lightDir = _WorldSpaceLightPos0.xyz;

float3 normal = normalize(i.worldNormal);

float NL = dot(normal, lightDir);

float3 baseColor = tex2D(_MainTex, i.uv);

float3 lightColor = _LightColor0;

col = fixed4(baseColor * lightColor * max(NL, 0), 0);

}

ENDCG

}

}

}プロパティとしてベースカラーをテクスチャで渡すことにします。

Properties

{

_MainTex ("Texture", 2D) = "white" {}

}シェーダのパスにはTags{"LightMode"="ForwardBase"}を指定します。

これでこのパスがForwardのベースパスとして呼ばれるようになります。

Pass

{

Tags { "LightMode"="ForwardBase"}

...頂点シェーダはフラグメントシェーダで必要なものを詰めているだけです。

フラグメントシェーダでは次のようにして平行光源の方向を取得しています。

float3 lightDir = _WorldSpaceLightPos0.xyz;_WorldSpaceLightPos0.xyzは現在扱っている光源が点光源の場合は光源の位置が、

平行光源の場合には光源の方向が渡ってくるようです。

ベースパスの場合は平行光源しか処理されないようなので

点光源の位置が渡ってくることはないようです。

「Create > Shader > Standard Surface Shader」でSurface Shaderを作成し、 「show generated code」で変換したコードを見てみると次のように記述されています。

#ifndef USING_DIRECTIONAL_LIGHT

fixed3 lightDir = normalize(UnityWorldSpaceLightDir(worldPos));

#else

fixed3 lightDir = _WorldSpaceLightPos0.xyz;

#endifSurface Shaderから生成されたコードについては次のページで詳しく解説されています。

ベースパスの場合は平行光源を扱うので常にUSING_DIRECTIONAL_LIGHTになるため

このような分岐は必要ないと思うのですが……。

ベースパスでは呼ばれないであろう方のUnityWorldSpaceLightDirは

UnityCG.cgincで定義されています。

定義は次のとおりです。

// Computes world space light direction, from world space position

inline float3 UnityWorldSpaceLightDir( in float3 worldPos )

{

#ifndef USING_LIGHT_MULTI_COMPILE

return _WorldSpaceLightPos0.xyz - worldPos * _WorldSpaceLightPos0.w;

#else

#ifndef USING_DIRECTIONAL_LIGHT

return _WorldSpaceLightPos0.xyz - worldPos;

#else

return _WorldSpaceLightPos0.xyz;

#endif

#endif

}この関数の中でもさらに分岐があるようですね。

ベースパスは平行光源のみなので

float3 lightDir = _WorldSpaceLightPos0.xyz;だけで済ませることにしました。

ライトの色は_LightColor0で取得します。

float3 lightColor = _LightColor0;_LightColor0はLighting.cgincでインクルードされている

UnityLightingCommon.cgincで定義されています。

Lighting.cgincをインクルードしておきましょう。

#include "UnityCG.cginc"

#include "Lighting.cginc"手に入れたライトの方向と色、そして法線からLambert反射を計算しています。

float NL = dot(normal, lightDir);

...

col = fixed4(baseColor * lightColor * max(NL, 0) 0);これでUnityの一番明るいDirectional Lightに対応してライティングが変わるようになります。

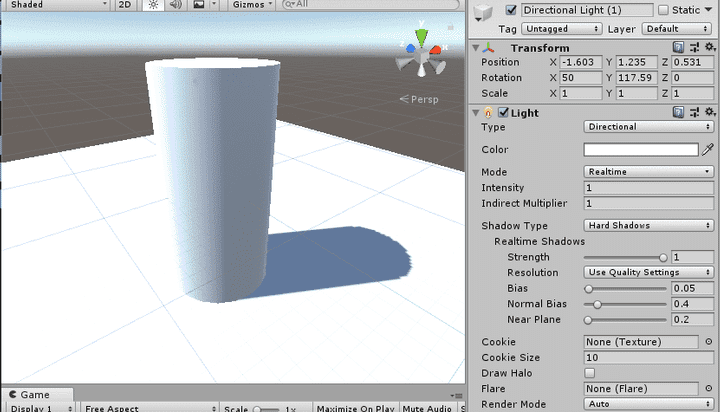

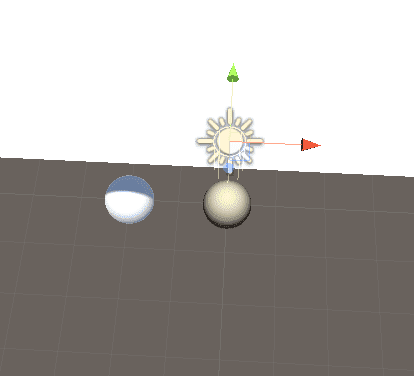

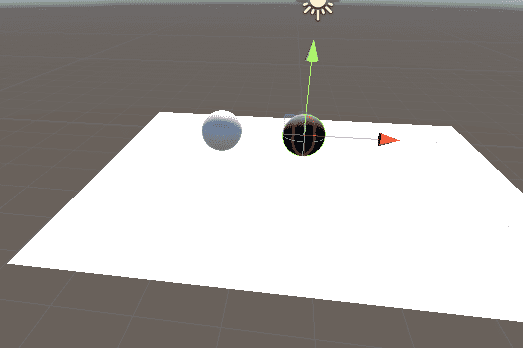

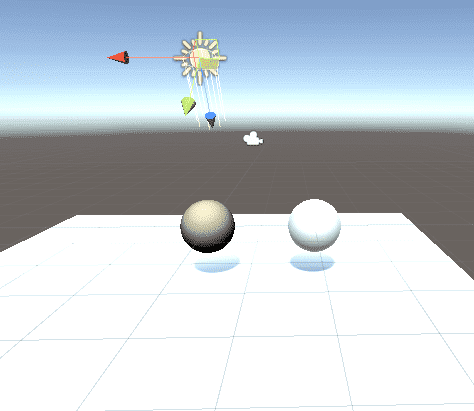

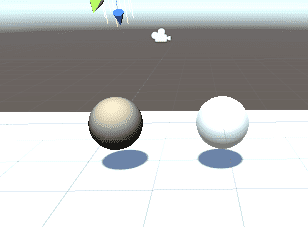

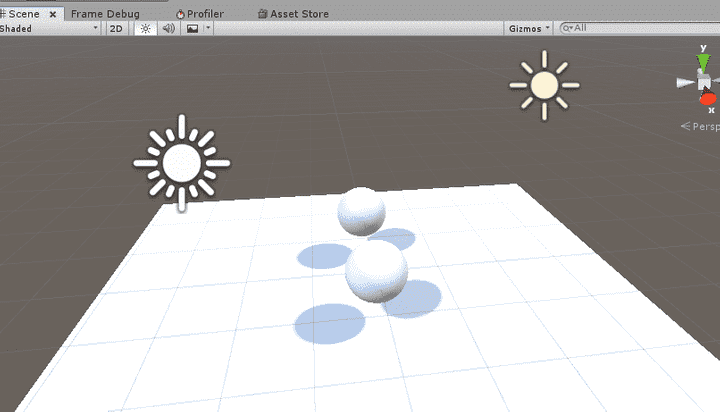

次の画像はライトを回転させてみた様子です。

シーンに平行光源が存在しない場合には_LightColor0に0が渡されてくるため

平行光源によるライトの影響は消えるようです。

影を落とすようにする

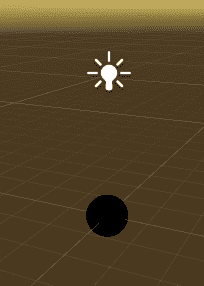

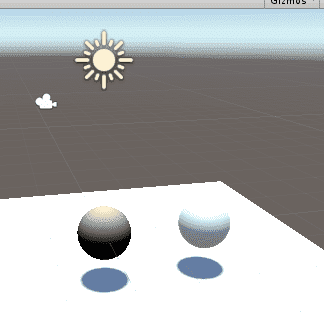

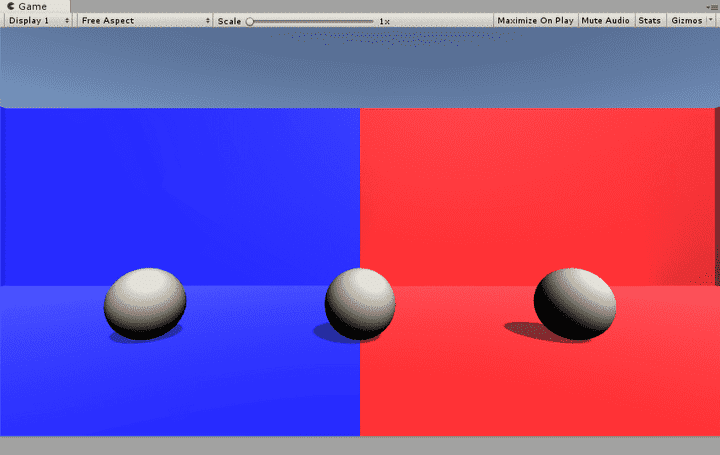

このマテリアルはまだ影を落としてくれません。 次の画像はStandard Shaderとの比較です。

影を落とすためにはパスを追加する必要があります。 これについてはUnityの公式マニュアルが詳しいです。

マニュアルにしたがって新しいパスを追加します。

Pass

{

Tags {"LightMode"="ShadowCaster"}

CGPROGRAM

#pragma vertex vert

#pragma fragment frag

#pragma multi_compile_shadowcaster

#include "UnityCG.cginc"

struct v2f {

V2F_SHADOW_CASTER;

};

v2f vert(appdata_base v)

{

v2f o;

TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)

return o;

}

float4 frag(v2f i) : SV_Target

{

SHADOW_CASTER_FRAGMENT(i)

}

ENDCG

}これで影を落とすようになりました。

マクロの中身

ShadowCasterパスで使われている

V2F_SHADOW_CASTER、TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)、

SHADOW_CASTER_FRAGMENT(i)はどれもUnityCG.cgincで定義されているマクロです。

順に見ていきます。

V2F_SHADOW_CASTER

V2F_SHADOW_CASTERの定義は次のとおりです。

#define V2F_SHADOW_CASTER V2F_SHADOW_CASTER_NOPOS UNITY_POSITION(pos)V2F_SHADOW_CASTER_NOPOSとUNITY_POSITION(pos)を順に並べたものとして

定義されています。

V2F_SHADOW_CASTER_NOPOSはUnityCG.cgincで次のように定義されています。

#if defined(SHADOWS_CUBE) && !defined(SHADOWS_CUBE_IN_DEPTH_TEX)

// Rendering into point light (cubemap) shadows

#define V2F_SHADOW_CASTER_NOPOS float3 vec : TEXCOORD0;

#define TRANSFER_SHADOW_CASTER_NOPOS_LEGACY(o,opos) o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz; opos = UnityObjectToClipPos(v.vertex);

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz; opos = UnityObjectToClipPos(v.vertex);

#define SHADOW_CASTER_FRAGMENT(i) return UnityEncodeCubeShadowDepth ((length(i.vec) + unity_LightShadowBias.x) * _LightPositionRange.w);

#else

// Rendering into directional or spot light shadows

#define V2F_SHADOW_CASTER_NOPOS

// Let embedding code know that V2F_SHADOW_CASTER_NOPOS is empty; so that it can workaround

// empty structs that could possibly be produced.

#define V2F_SHADOW_CASTER_NOPOS_IS_EMPTY

#define TRANSFER_SHADOW_CASTER_NOPOS_LEGACY(o,opos) \

opos = UnityObjectToClipPos(v.vertex.xyz); \

opos = UnityApplyLinearShadowBias(opos);

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) \

opos = UnityClipSpaceShadowCasterPos(v.vertex, v.normal); \

opos = UnityApplyLinearShadowBias(opos);

#define SHADOW_CASTER_FRAGMENT(i) return 0;

#endifSHADOWS_CUBEなどはShader Variantです。

Shader Variantについては次のページがわかりやすいです。

見たところシャドウマップにキューブマップを使うポイントライトと それ以外のライトで分岐しているようです。 キューブマップでもデプステクスチャを利用している場合は後者が呼ばれるようです。 デプステクスチャでないキューブマップはレガシーなものだそうです。

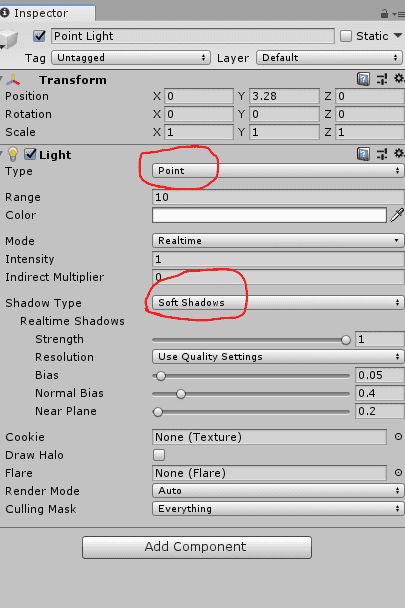

SHADOWS_CUBEの定義はcgincファイルには見当たらないので実行時に渡されるもののようです。

試しに影のあるポイントライトを設定してみるとSHADOWS_CUBEが定義されました。

SHADOWS_CUBE_IN_DEPTH_TEXはUnityCG.cgincで次のように定義されていました。

#if defined(SHADER_API_D3D11) || defined(SHADER_API_PSSL) || defined(SHADER_API_METAL) || defined(SHADER_API_GLCORE) || defined(SHADER_API_GLES3) || defined(SHADER_API_VULKAN) || defined(SHADER_API_SWITCH) // D3D11, D3D12, XB1, PS4, iOS, macOS, tvOS, glcore, gles3, webgl2.0, Switch

// Real-support for depth-format cube shadow map.

#define SHADOWS_CUBE_IN_DEPTH_TEX

#endifプラットフォームによって分岐しているようですね。

デプステクスチャでないキューブマップの場合は

V2F_SHADOW_CASTER_NOPOSが次のように定義されています。

#define V2F_SHADOW_CASTER_NOPOS float3 vec : TEXCOORD0;キューブマップ用のベクトルをv2fに定義しているようです。

デプステクスチャでないキューブマップ以外の場合はV2F_SHADOW_CASTER_NOPOSが空のようです。

#define V2F_SHADOW_CASTER_NOPOS次にUNITY_POSITION(pos)を見てみます。

UNITY_POSITION(pos)はUnityCG.cgincで次のように定義されています。

// On D3D reading screen space coordinates from fragment shader requires SM3.0

#define UNITY_POSITION(pos) float4 pos : SV_POSITIONSV_POSITIONを定義しているだけのようですね。

まとめると、デプステクスチャでないキューブマップのときにはv2fにvecとposを、 それ以外の場合にはposのみを定義するマクロということになります。

TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)

次に頂点シェーダで呼ばれている

TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)を見ていきます。

TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)の定義は次のとおりです。

// Vertex shader part, with support for normal offset shadows. Requires

// position and normal to be present in the vertex input.

#define TRANSFER_SHADOW_CASTER_NORMALOFFSET(o) TRANSFER_SHADOW_CASTER_NOPOS(o,o.pos)TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)は

TRANSFER_SHADOW_CASTER_NOPOS(o,o.pos)に書き換わるだけのようです。

TRANSFER_SHADOW_CASTER_NOPOS(o,o.pos)は先ほどと同じ場所で定義されています。

#if defined(SHADOWS_CUBE) && !defined(SHADOWS_CUBE_IN_DEPTH_TEX)

// Rendering into point light (cubemap) shadows

#define V2F_SHADOW_CASTER_NOPOS float3 vec : TEXCOORD0;

#define TRANSFER_SHADOW_CASTER_NOPOS_LEGACY(o,opos) o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz; opos = UnityObjectToClipPos(v.vertex);

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz; opos = UnityObjectToClipPos(v.vertex);

#define SHADOW_CASTER_FRAGMENT(i) return UnityEncodeCubeShadowDepth ((length(i.vec) + unity_LightShadowBias.x) * _LightPositionRange.w);

#else

// Rendering into directional or spot light shadows

#define V2F_SHADOW_CASTER_NOPOS

// Let embedding code know that V2F_SHADOW_CASTER_NOPOS is empty; so that it can workaround

// empty structs that could possibly be produced.

#define V2F_SHADOW_CASTER_NOPOS_IS_EMPTY

#define TRANSFER_SHADOW_CASTER_NOPOS_LEGACY(o,opos) \

opos = UnityObjectToClipPos(v.vertex.xyz); \

opos = UnityApplyLinearShadowBias(opos);

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) \

opos = UnityClipSpaceShadowCasterPos(v.vertex, v.normal); \

opos = UnityApplyLinearShadowBias(opos);

#define SHADOW_CASTER_FRAGMENT(i) return 0;

#endifデプステクスチャでないキューブマップの場合は次のようになるようです。

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz; opos = UnityObjectToClipPos(v.vertex);_LightPositionRangeはUnityShaderVariables.cgincで次のように記述されています。

float4 _LightPositionRange; // xyz = pos, w = 1/range_LightPositionRange.xyzはライトの座標のようですね。

頂点のワールド座標からライトの座標を引いてvecに代入し、

posにはクリップ座標を計算して入れているようです。

デプステクスチャでないキューブマップ以外の場合次のようになります。

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) \

opos = UnityClipSpaceShadowCasterPos(v.vertex, v.normal); \

opos = UnityApplyLinearShadowBias(opos);UnityClipSpaceShadowCasterPos(v.vertex, v.normal);の呼び出しと

UnityApplyLinearShadowBias(opos);の呼び出しに展開されるようです。

それぞれ順番に見ていきます。

UnityClipSpaceShadowCasterPos(v.vertex, v.normal)は

UnityCG.cgincで次のように定義されています。

float4 UnityClipSpaceShadowCasterPos(float4 vertex, float3 normal)

{

float4 wPos = mul(unity_ObjectToWorld, vertex);

if (unity_LightShadowBias.z != 0.0)

{

float3 wNormal = UnityObjectToWorldNormal(normal);

float3 wLight = normalize(UnityWorldSpaceLightDir(wPos.xyz));

// apply normal offset bias (inset position along the normal)

// bias needs to be scaled by sine between normal and light direction

// (http://the-witness.net/news/2013/09/shadow-mapping-summary-part-1/)

//

// unity_LightShadowBias.z contains user-specified normal offset amount

// scaled by world space texel size.

float shadowCos = dot(wNormal, wLight);

float shadowSine = sqrt(1-shadowCos*shadowCos);

float normalBias = unity_LightShadowBias.z * shadowSine;

wPos.xyz -= wNormal * normalBias;

}

return mul(UNITY_MATRIX_VP, wPos);

}

// Legacy, not used anymore; kept around to not break existing user shaders

float4 UnityClipSpaceShadowCasterPos(float3 vertex, float3 normal)

{

return UnityClipSpaceShadowCasterPos(float4(vertex, 1), normal);

}オフセットが与えられた場合に それを考慮してノーマル方向に縮小して、 それからClipスペースのポジションを計算するようです。 コメントにあるページでこのオフセットの計算について書かれています。

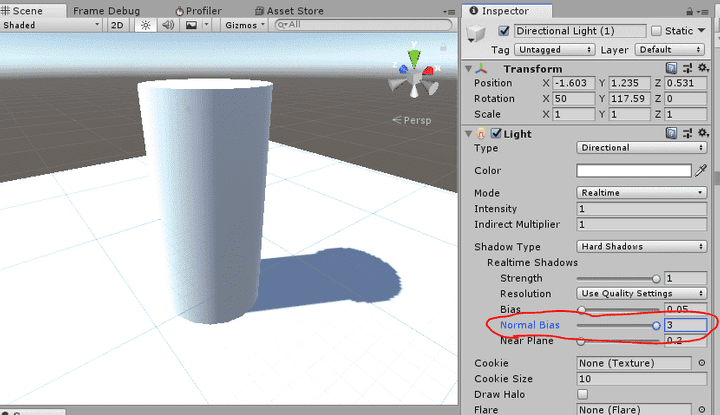

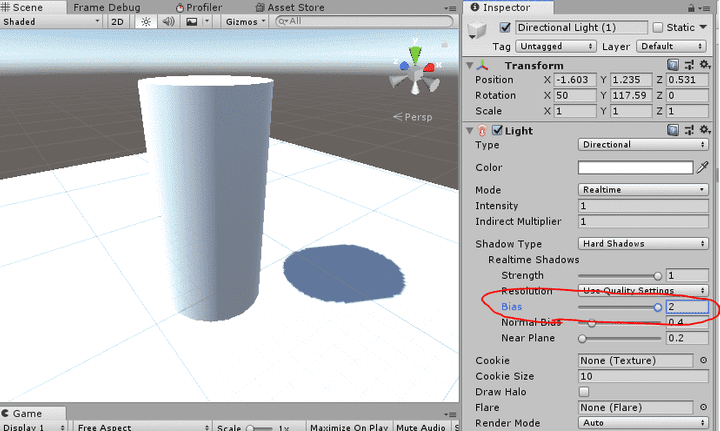

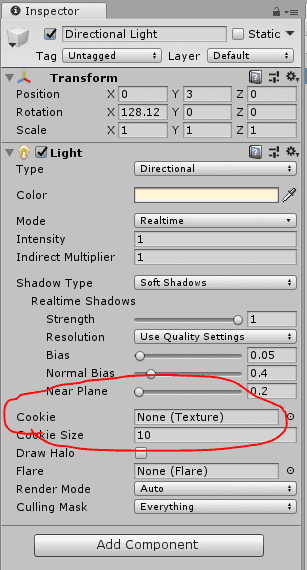

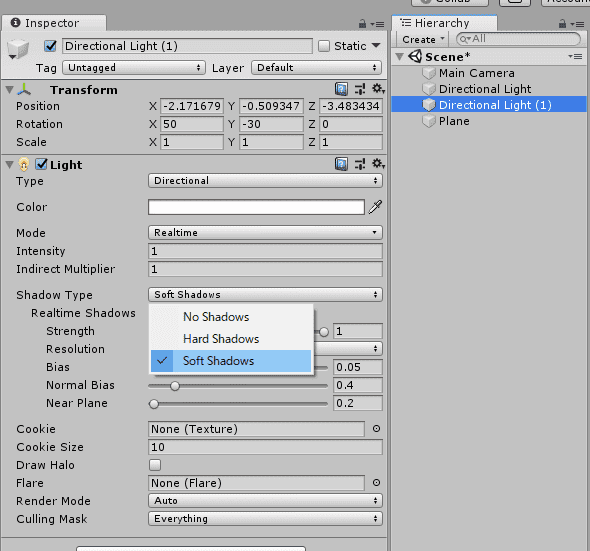

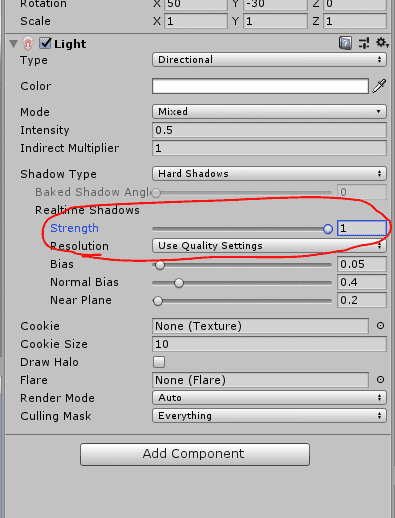

バイアスの量は各ライトの設定で与えられるようです。

ライトの設定の「Normal Bias」の値をいじると 確かに影がノーマル方向に縮小されているのがわかります。

次にUnityApplyLinearShadowBias(opos)を見てみます。

UnityApplyLinearShadowBias(opos)はUnityCG.cgincで次のように定義されています。

float4 UnityApplyLinearShadowBias(float4 clipPos)

{

// For point lights that support depth cube map, the bias is applied in the fragment shader sampling the shadow map.

// This is because the legacy behaviour for point light shadow map cannot be implemented by offseting the vertex position

// in the vertex shader generating the shadow map.

#if !(defined(SHADOWS_CUBE) && defined(SHADOWS_CUBE_IN_DEPTH_TEX))

#if defined(UNITY_REVERSED_Z)

// We use max/min instead of clamp to ensure proper handling of the rare case

// where both numerator and denominator are zero and the fraction becomes NaN.

clipPos.z += max(-1, min(unity_LightShadowBias.x / clipPos.w, 0));

#else

clipPos.z += saturate(unity_LightShadowBias.x/clipPos.w);

#endif

#endif

#if defined(UNITY_REVERSED_Z)

float clamped = min(clipPos.z, clipPos.w*UNITY_NEAR_CLIP_VALUE);

#else

float clamped = max(clipPos.z, clipPos.w*UNITY_NEAR_CLIP_VALUE);

#endif

clipPos.z = lerp(clipPos.z, clamped, unity_LightShadowBias.y);

return clipPos;

}#if !(defined(SHADOWS_CUBE) && defined(SHADOWS_CUBE_IN_DEPTH_TEX))

と書かれていますが、今回は

defined(SHADOWS_CUBE) && defined(SHADOWS_CUBE_IN_DEPTH_TEX)でないときに

この関数を呼んでいるのでこの分岐の中は実行されます。

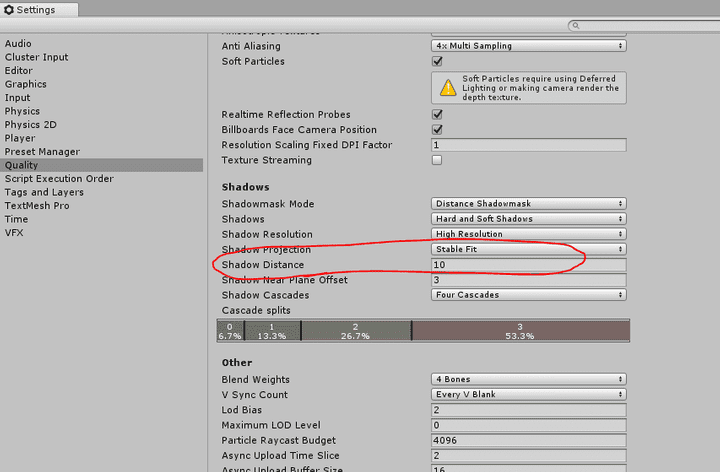

unity_LightShadowBias.xとunity_LightShadowBias.yについては情報がないので

よくわからないのですが、ライトの設定に「Normal Bias」と「Bias」が存在するので、

こちらでは「Bias」の方を処理しているものと思われます。

クリップスペースのzを増加させてクランプしています。

UNITY_REVERSED_Zは特定の環境でZの向きが逆向きになっているものに対応しているようです。

Zの向きについては次のページに解説がありました。

これらのバイアスの計算はシャドウアクネ(Shadow Acne)の対策です。 シャドウアクネについては次のページがわかりやすいです。

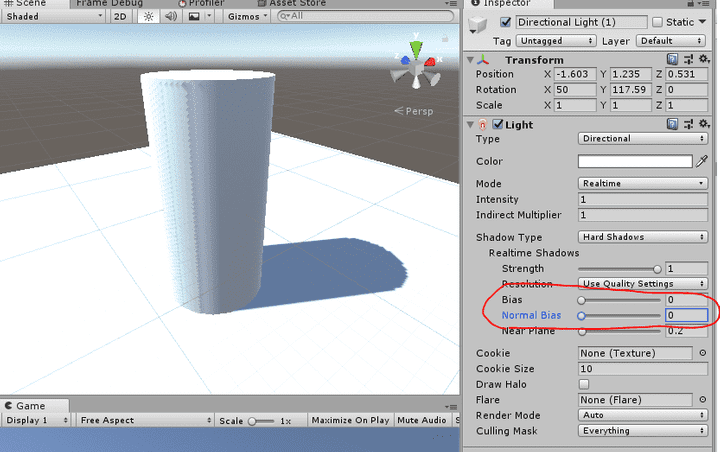

ライトのデフォルト設定では影には問題がなさそうに見えます。

バイアスを両方とも0にするとシャドウアクネの発生が確認できます。

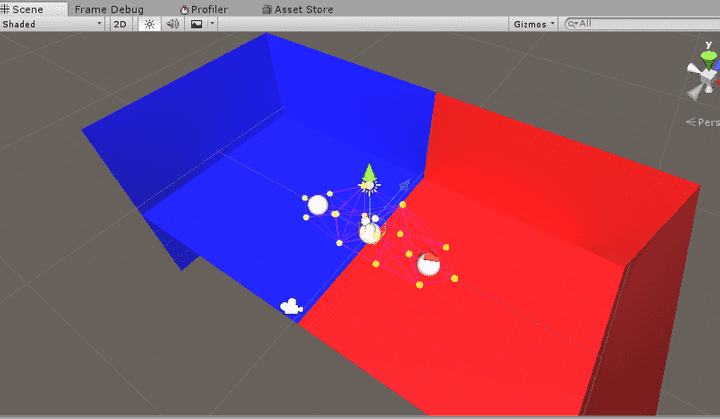

バイアスが小さいとその分シャドウアクネが起きやすくなります。 しかし、バイアスを大きくするとそれはそれで別の問題が発生します。

影が痩せてしまったり、 ピーターパン現象という影がオブジェクトから離れてしまう現象などが 発生しています。

これらのバイアスの最適な値はシーンに応じて変わってくるので、 シーンに合わせて調整する必要があります。

まとめると、頂点シェーダに与える

TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)マクロは次のような動作になります。

デプステクスチャでないキューブマップの場合は

vecとクリップスペースの位置を計算します。

それ以外の場合ではシャドウアクネ対策としてNormal BiasとBiasを与えて

クリップスペースを計算します。

SHADOW_CASTER_FRAGMENT(i)

フラグメントシェーダの

SHADOW_CASTER_FRAGMENT(i)についてもさきほどと同様の場所で定義されています。

#if defined(SHADOWS_CUBE) && !defined(SHADOWS_CUBE_IN_DEPTH_TEX)

// Rendering into point light (cubemap) shadows

#define V2F_SHADOW_CASTER_NOPOS float3 vec : TEXCOORD0;

#define TRANSFER_SHADOW_CASTER_NOPOS_LEGACY(o,opos) o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz; opos = UnityObjectToClipPos(v.vertex);

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz; opos = UnityObjectToClipPos(v.vertex);

#define SHADOW_CASTER_FRAGMENT(i) return UnityEncodeCubeShadowDepth ((length(i.vec) + unity_LightShadowBias.x) * _LightPositionRange.w);

#else

// Rendering into directional or spot light shadows

#define V2F_SHADOW_CASTER_NOPOS

// Let embedding code know that V2F_SHADOW_CASTER_NOPOS is empty; so that it can workaround

// empty structs that could possibly be produced.

#define V2F_SHADOW_CASTER_NOPOS_IS_EMPTY

#define TRANSFER_SHADOW_CASTER_NOPOS_LEGACY(o,opos) \

opos = UnityObjectToClipPos(v.vertex.xyz); \

opos = UnityApplyLinearShadowBias(opos);

#define TRANSFER_SHADOW_CASTER_NOPOS(o,opos) \

opos = UnityClipSpaceShadowCasterPos(v.vertex, v.normal); \

opos = UnityApplyLinearShadowBias(opos);

#define SHADOW_CASTER_FRAGMENT(i) return 0;

#endifデプステクスチャでないキューブマップの場合とそれ以外の場合で分岐しています。 デプステクスチャでないキューブマップでない場合には単純に0を返すようになっています。 デプスを利用しているので色は0でも問題ないのでしょう。 デプステクスチャでないキューブマップの場合はここでバイアスを計算しているようですね。

UnityEncodeCubeShadowDepthの定義は次のとおりです。

// Encoding/decoding [0..1) floats into 8 bit/channel RGBA. Note that 1.0 will not be encoded properly.

inline float4 EncodeFloatRGBA( float v )

{

float4 kEncodeMul = float4(1.0, 255.0, 65025.0, 16581375.0);

float kEncodeBit = 1.0/255.0;

float4 enc = kEncodeMul * v;

enc = frac (enc);

enc -= enc.yzww * kEncodeBit;

return enc;

}

float4 UnityEncodeCubeShadowDepth (float z)

{

#ifdef UNITY_USE_RGBA_FOR_POINT_SHADOWS

return EncodeFloatRGBA (min(z, 0.999));

#else

return z;

#endif

}浮動小数点数の書き出しに対応している場合にはそのままで、 そうでない場合にはfloatをrgbaに詰め込んでいるようです。

マクロを展開して整理すると次のようになります。

Pass

{

Name "ShadowCast"

Tags {"LightMode" = "ShadowCaster"}

CGPROGRAM

#pragma vertex vert

#pragma fragment frag

#pragma multi_compile_shadowcaster

#include "UnityCG.cginc"

struct v2f {

// V2F_SHADOW_CASTER;

float4 pos : SV_POSITION;

#if defined(SHADOWS_CUBE) && !defined(SHADOWS_CUBE_IN_DEPTH_TEX)

float3 vec : TEXCOORD0;

#endif

};

void vert(in appdata_base v, out v2f o)

{

// TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)

#if defined(SHADOWS_CUBE) && !defined(SHADOWS_CUBE_IN_DEPTH_TEX)

o.vec = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz;

o.pos = UnityObjectToClipPos(v.vertex);

#else

o.pos = UnityClipSpaceShadowCasterPos(v.vertex, v.normal);

o.pos = UnityApplyLinearShadowBias(o.pos);

#endif

}

float4 frag(v2f i) : SV_Target

{

// SHADOW_CASTER_FRAGMENT(i)

#if defined(SHADOWS_CUBE) && !defined(SHADOWS_CUBE_IN_DEPTH_TEX)

return UnityEncodeCubeShadowDepth ((length(i.vec) + unity_LightShadowBias.x) * _LightPositionRange.w);

#else

return 0;

#endif

}

ENDCG

}影を受けるようにする

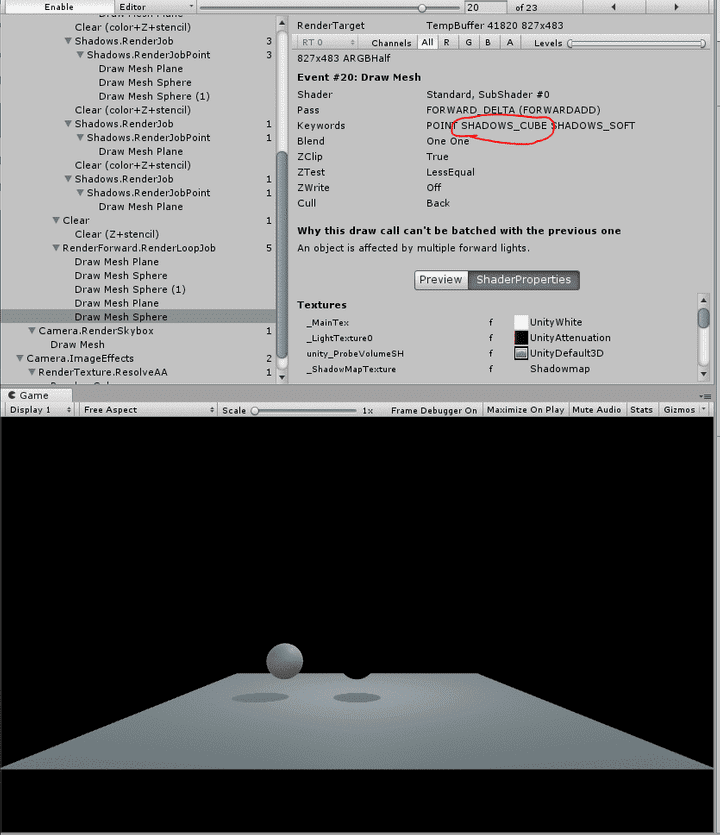

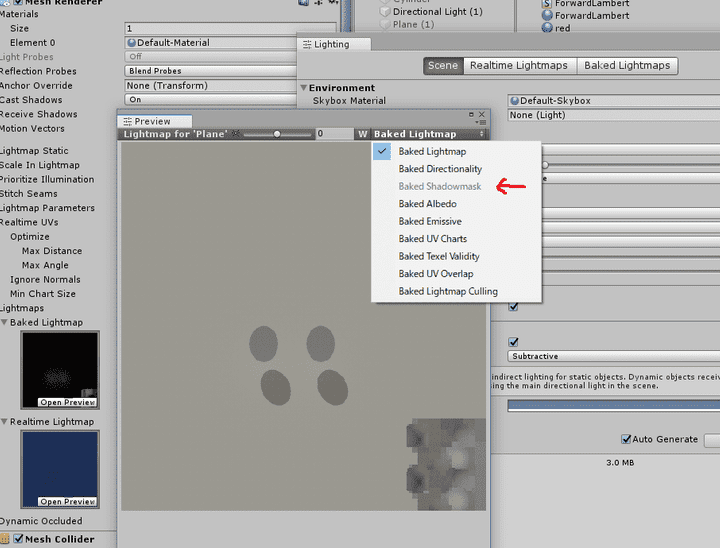

現状ではまだ影を受けることができません。 次の画像はStandard Shaderとの比較です。

マニュアルに影を受ける例も載っているのですが、 Surface Shaderから生成したコードと少し異なるようです。

マニュアルではSHADOW_COORDS(n)、TRANSFER_SHADOW(o)、

そしてSHADOW_ATTENUATION(i)というマクロ使っています。

Surface Shaderから生成したコードではUNITY_SHADOW_COORDS(n)、

UNITY_TRANSFER_SHADOW(o,coord)、

それからUNITY_LIGHT_ATTENUATION(attenuation, i, worldPos)というマクロ使っています。

今回はSurface Shaderから生成したコードをベースにします。

まずは#pragmaを追加します。

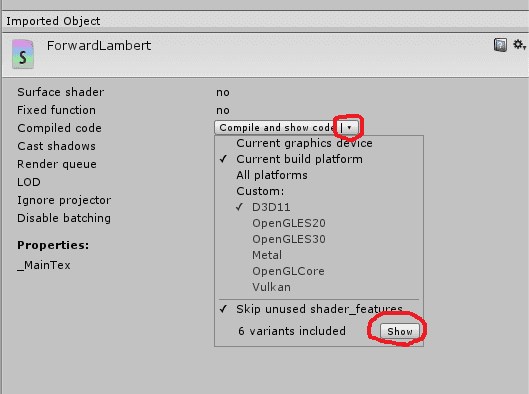

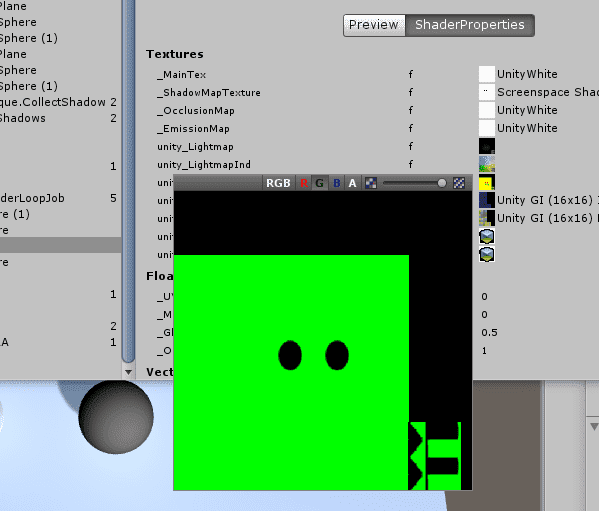

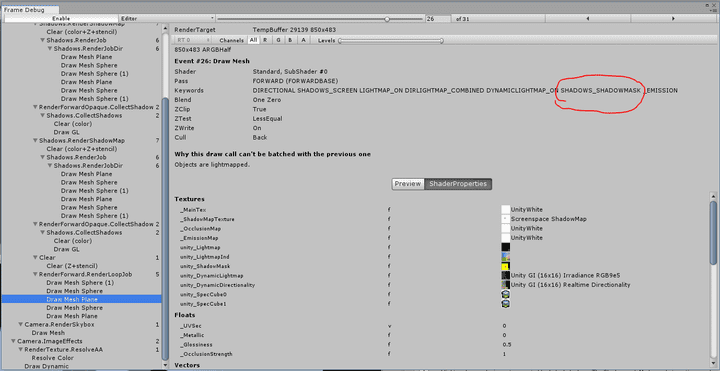

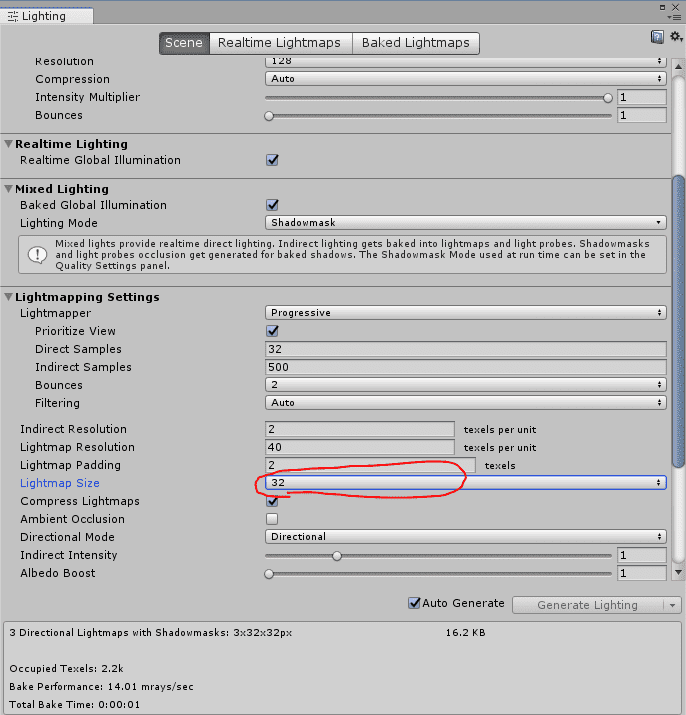

#pragma multi_compile_fwdbase nolightmap nodirlightmap nodynlightmap novertexlight「Compiled code」の「Compile adn show code」の右の矢印から「Show」で 生成されるキーワードを確認できます。

この#pragmaで次のようなキーワードが生成されるようです。

// -----------------------------------------

// Snippet #1 platforms ffffffff:

Builtin keywords used: DIRECTIONAL LIGHTMAP_SHADOW_MIXING LIGHTPROBE_SH SHADOWS_SCREEN SHADOWS_SHADOWMASK

4 keyword variants used in scene:

DIRECTIONAL

DIRECTIONAL LIGHTPROBE_SH

DIRECTIONAL SHADOWS_SCREEN

DIRECTIONAL LIGHTPROBE_SH SHADOWS_SCREEN次に#include "AutoLight.cginc"を加えます。

#include "UnityCG.cginc"

#include "Lighting.cginc"

#include "AutoLight.cginc"この#includeしたファイルの中で定義されているマクロを利用します。

appdata構造体を書き換えます。

struct appdata

{

float4 vertex : POSITION;

float3 normal : NORMAL;

float2 uv : TEXCOORD0;

float2 texcoord1: TEXCOORD1;

};float2 texcoord1: TEXCOORD1;を追加しました。

ライトマップがある場合にライトマップのUVが渡されてきます。

v2f構造体を次のように書き換えます。

struct v2f

{

// float4 vertex : SV_POSITION;

float4 pos : SV_POSITION;

float2 uv : TEXCOORD0;

float3 worldNormal : TEXCOORD1;

float3 worldPos : TEXCOORD2;

#ifdef UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS

UNITY_LIGHTING_COORDS(3,4)

#else

UNITY_SHADOW_COORDS(3)

#endif

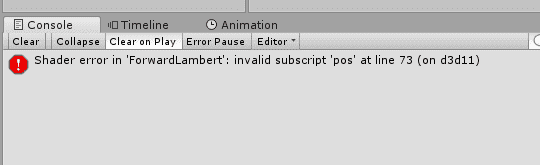

};posの名前を決め打ちでマクロが作られているようで、

別の名前だとエラーが出ます。

そのためvertexからposに名前を変えています。

worldPosも追加します。

UNITY_LIGHTING_COORDS(3,4)もしくはUNITY_SHADOW_COORDS(3)を

構造体に追加しています。

数字は使われるTEXCOORDNのNです。

worldNormalとworldPos、uvでTEXCOORD2まで使っているので3と4を指定しました。

頂点シェーダにUNITY_INITIALIZE_OUTPUT(v2f, o);と

UNITY_TRANSFER_SHADOW(o,v.texcoord1.xy);を追加します。

void vert (in appdata v, out v2f o)

{

UNITY_INITIALIZE_OUTPUT(v2f, o);

o.pos = UnityObjectToClipPos(v.vertex);

o.worldNormal = UnityObjectToWorldNormal(v.normal);

o.worldPos = mul(unity_ObjectToWorld, v.vertex);

o.uv = TRANSFORM_TEX(v.uv, _MainTex);

UNITY_TRANSFER_LIGHTING(o,v.texcoord1.xy);

}フラグメントシェーダでUNITY_LIGHT_ATTENUATION(attenuation, i, i.worldPos);を使います。

このマクロで定義されるattenuationは影で0、光の当たる部分で1となります。

attenuationをライティング結果にかけ合わせます。

void frag (in v2f i, out fixed4 col : SV_Target)

{

float3 lightDir = _WorldSpaceLightPos0.xyz;

float3 normal = normalize(i.worldNormal);

float NL = dot(normal, lightDir);

UNITY_LIGHT_ATTENUATION(attenuation, i, i.worldPos);

float3 baseColor = tex2D(_MainTex, i.uv);

float3 lightColor = _LightColor0;

col = fixed4(baseColor * lightColor * max(NL, 0) * attenuation, 0);

}これで影を受け取れるようになりました。

マクロの中身

v2f構造体に追加したマクロ

v2f構造体に次のようなマクロを追加しました。

#ifdef UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS

UNITY_LIGHTING_COORDS(3,4)

#else

UNITY_SHADOW_COORDS(3)

#endifこの場合分けはSurface Shaderから生成したコードにならっています。

Surface Shaderから生成したコードは次のとおりです。

#ifndef LIGHTMAP_ON

// half-precision fragment shader registers:

#ifdef UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS

#define FOG_COMBINED_WITH_WORLD_POS

struct v2f_surf {

UNITY_POSITION(pos);

float2 pack0 : TEXCOORD0; // _MainTex

float3 worldNormal : TEXCOORD1;

float4 worldPos : TEXCOORD2;

#if UNITY_SHOULD_SAMPLE_SH

half3 sh : TEXCOORD3; // SH

#endif

UNITY_LIGHTING_COORDS(4,5)

#if SHADER_TARGET >= 30

float4 lmap : TEXCOORD6;

#endif

UNITY_VERTEX_INPUT_INSTANCE_ID

UNITY_VERTEX_OUTPUT_STEREO

};

#endif

// high-precision fragment shader registers:

#ifndef UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS

struct v2f_surf {

UNITY_POSITION(pos);

float2 pack0 : TEXCOORD0; // _MainTex

float3 worldNormal : TEXCOORD1;

float3 worldPos : TEXCOORD2;

#if UNITY_SHOULD_SAMPLE_SH

half3 sh : TEXCOORD3; // SH

#endif

UNITY_FOG_COORDS(4)

UNITY_SHADOW_COORDS(5)

#if SHADER_TARGET >= 30

float4 lmap : TEXCOORD6;

#endif

UNITY_VERTEX_INPUT_INSTANCE_ID

UNITY_VERTEX_OUTPUT_STEREO

};

#endif

#endif

// with lightmaps:

#ifdef LIGHTMAP_ON

// half-precision fragment shader registers:

#ifdef UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS

#define FOG_COMBINED_WITH_WORLD_POS

struct v2f_surf {

UNITY_POSITION(pos);

float2 pack0 : TEXCOORD0; // _MainTex

float3 worldNormal : TEXCOORD1;

float4 worldPos : TEXCOORD2;

float4 lmap : TEXCOORD3;

UNITY_LIGHTING_COORDS(4,5)

UNITY_VERTEX_INPUT_INSTANCE_ID

UNITY_VERTEX_OUTPUT_STEREO

};

#endif

// high-precision fragment shader registers:

#ifndef UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS

struct v2f_surf {

UNITY_POSITION(pos);

float2 pack0 : TEXCOORD0; // _MainTex

float3 worldNormal : TEXCOORD1;

float3 worldPos : TEXCOORD2;

float4 lmap : TEXCOORD3;

UNITY_FOG_COORDS(4)

UNITY_SHADOW_COORDS(5)

#ifdef DIRLIGHTMAP_COMBINED

float3 tSpace0 : TEXCOORD6;

float3 tSpace1 : TEXCOORD7;

float3 tSpace2 : TEXCOORD8;

#endif

UNITY_VERTEX_INPUT_INSTANCE_ID

UNITY_VERTEX_OUTPUT_STEREO

};

#endif

#endifUNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERSについて次のページ説明がありました。

UNITYHALFPRECISIONFRAGMENTSHADERREGISTERS : UNITYHALFPRECISIONFRAGMENTSHADERREGISTERS is set automatically for platforms that don't require full floating-point precision support in fragment shaders.

デスクトップではfloatもhalfもfixedも全部32bit精度で計算されます。

これのことを言っているのだとしたら、 デスクトップとそれ以外で場合分けしているということなのでしょうか。

結局今回調べた範囲ではこの場合分けは必要ないように思えます。

この場合分けはベースパスにのみ書かれていました。

ベースパスでは平行光源のみ扱います。

後で見ますが、平行光源の場合はUNITY_LIGHTING_COORDS(3,4)と

UNITY_SHADOW_COORDS(3)はほとんど同じものになります。

UNITY_LIGHTING_COORDS(3,4)について見ていきます。

AutoLight.cgincで次のように定義されています。

#define UNITY_LIGHTING_COORDS(idx1, idx2) DECLARE_LIGHT_COORDS(idx1) UNITY_SHADOW_COORDS(idx2)DECLARE_LIGHT_COORDS(idx1)とUNITY_SHADOW_COORDS(idx2)に展開されます。

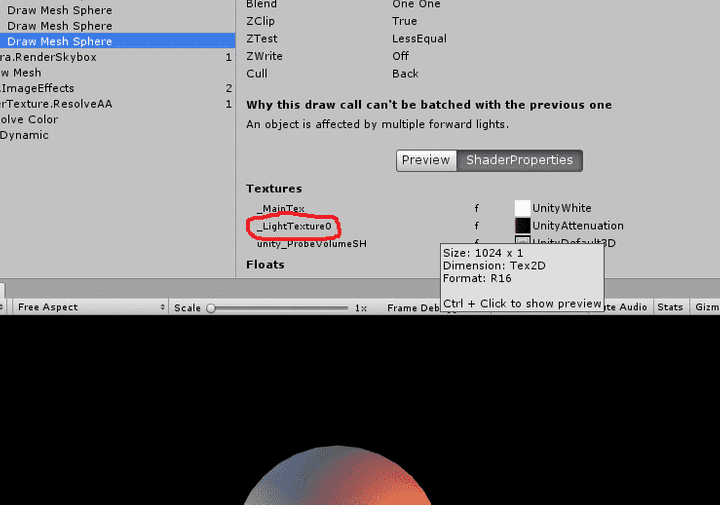

DECLARE_LIGHT_COORDS(idx1)について見てみます。

AutoLight.cgincで次のとおり定義されていました。

#ifdef POINT

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord3 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xyz;

# define LIGHT_ATTENUATION(a) (tex2D(_LightTexture0, dot(a._LightCoord,a._LightCoord).rr).r * SHADOW_ATTENUATION(a))

#endif

#ifdef SPOT

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord4 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex));

# define LIGHT_ATTENUATION(a) ( (a._LightCoord.z > 0) * UnitySpotCookie(a._LightCoord) * UnitySpotAttenuate(a._LightCoord.xyz) * SHADOW_ATTENUATION(a) )

#endif

#ifdef DIRECTIONAL

# define DECLARE_LIGHT_COORDS(idx)

# define COMPUTE_LIGHT_COORDS(a)

# define LIGHT_ATTENUATION(a) SHADOW_ATTENUATION(a)

#endif

#ifdef POINT_COOKIE

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord3 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xyz;

# define LIGHT_ATTENUATION(a) (tex2D(_LightTextureB0, dot(a._LightCoord,a._LightCoord).rr).r * texCUBE(_LightTexture0, a._LightCoord).w * SHADOW_ATTENUATION(a))

#endif

#ifdef DIRECTIONAL_COOKIE

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord2 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xy;

# define LIGHT_ATTENUATION(a) (tex2D(_LightTexture0, a._LightCoord).w * SHADOW_ATTENUATION(a))

#endifライトの種類によって変わってくるようです。

DIRECTIONALの場合を見てみると次のとおりです。

#ifdef DIRECTIONAL

# define DECLARE_LIGHT_COORDS(idx)

# define COMPUTE_LIGHT_COORDS(a)

# define LIGHT_ATTENUATION(a) SHADOW_ATTENUATION(a)

#endifDECLARE_LIGHT_COORDS(idx)は空です。

つまりDIRECTIONALの場合はUNITY_LIGHTING_COORDS(3,4)は

ただUNITY_SHADOW_COORDS(4)に展開されることになります。

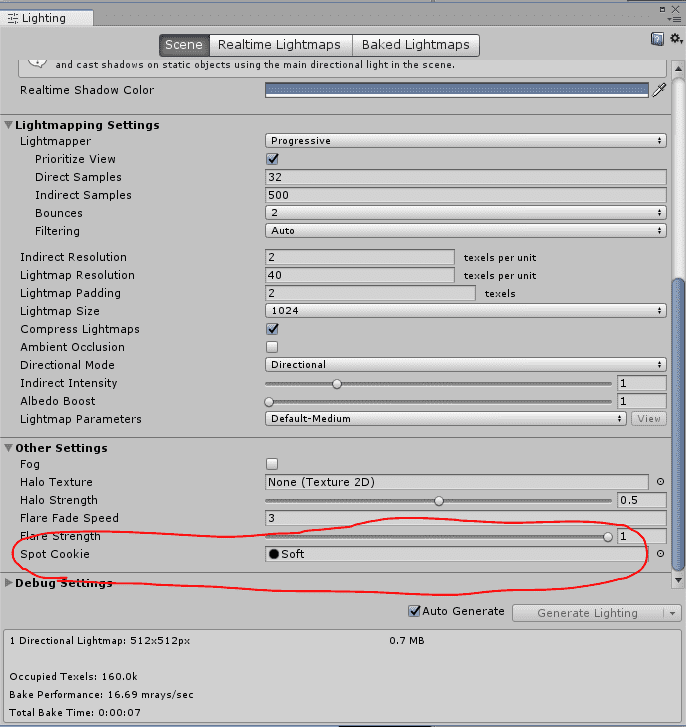

DIRECTIONAL_COOKIEについても平行光源っぽいので見てみます。

クッキーについては次のページに解説があります。 マスクのテクスチャを使ってライトの形状を変更する機能です。

ライトの設定からクッキーを指定できます。

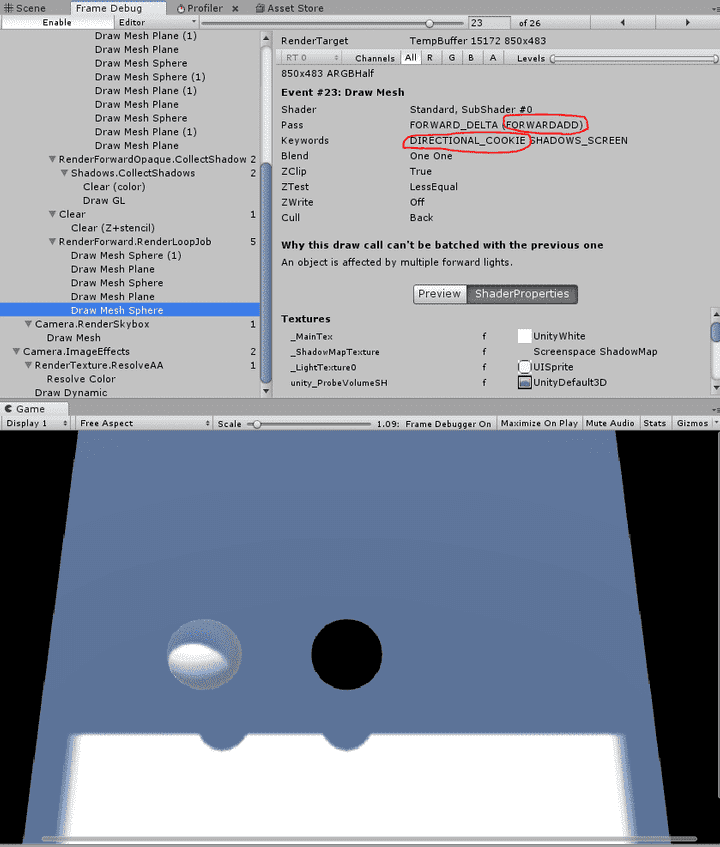

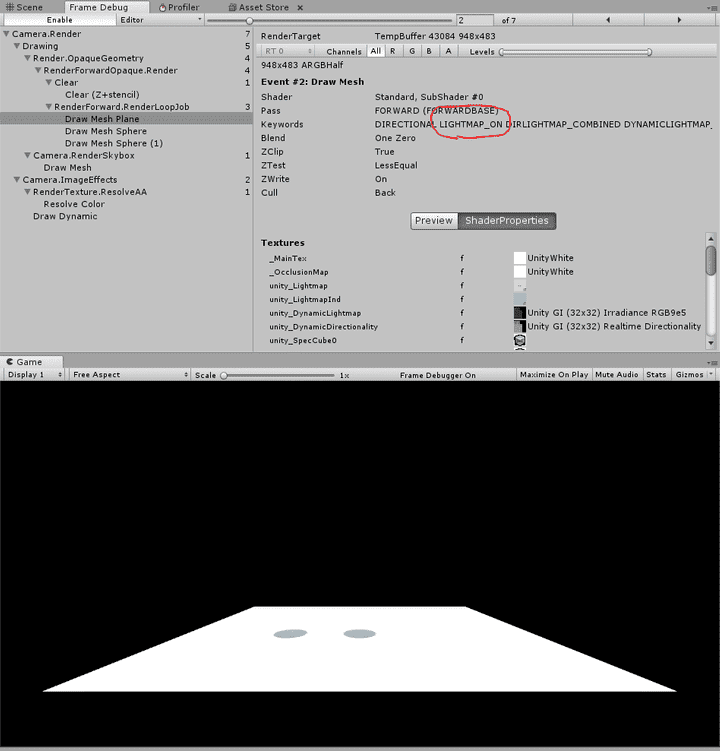

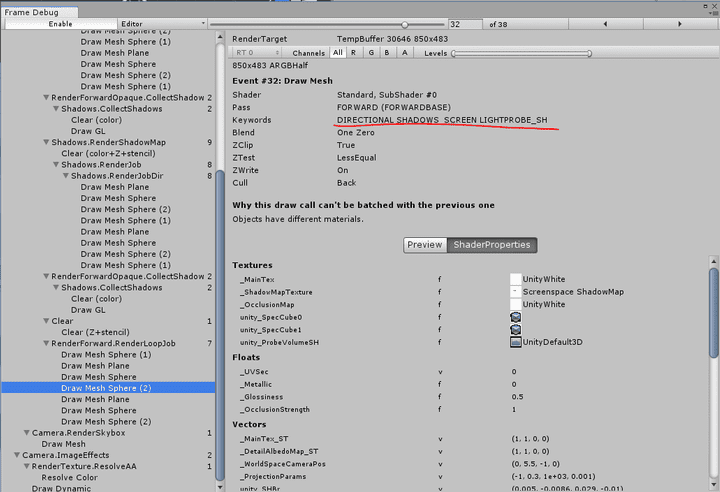

フレームデバッガを確認してみると、 クッキーを設定した平行光源は加算パスで計算されているようです。

ベースパスの場合は単純な平行光源しか扱わないためUNITY_SHADOW_COORDSの

場合だけを考えれば良さそうです。

UNITY_SHADOW_COORDSについて見ていきます。

AutoLight.cgincに次のように定義されています。

#if defined(HANDLE_SHADOWS_BLENDING_IN_GI) // handles shadows in the depths of the GI function for performance reasons

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) SHADOW_ATTENUATION(a)

#elif defined(SHADOWS_SCREEN) && !defined(LIGHTMAP_ON) && !defined(UNITY_NO_SCREENSPACE_SHADOWS) // no lightmap uv thus store screenPos instead

// can happen if we have two directional lights. main light gets handled in GI code, but 2nd dir light can have shadow screen and mask.

// - Disabled on ES2 because WebGL 1.0 seems to have junk in .w (even though it shouldn't)

# if defined(SHADOWS_SHADOWMASK) && !defined(SHADER_API_GLES)

# define UNITY_SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

# define UNITY_TRANSFER_SHADOW(a, coord) {a._ShadowCoord.xy = coord * unity_LightmapST.xy + unity_LightmapST.zw; a._ShadowCoord.zw = ComputeScreenPos(a.pos).xy;}

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, worldPos, float4(a._ShadowCoord.zw, 0.0, UNITY_SHADOW_W(a.pos.w)));

# else

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, a._ShadowCoord)

# endif

#else

# define UNITY_SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

# if defined(SHADOWS_SHADOWMASK)

# define UNITY_TRANSFER_SHADOW(a, coord) a._ShadowCoord.xy = coord.xy * unity_LightmapST.xy + unity_LightmapST.zw;

# if (defined(SHADOWS_DEPTH) || defined(SHADOWS_SCREEN) || defined(SHADOWS_CUBE) || UNITY_LIGHT_PROBE_PROXY_VOLUME)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, 0, 0)

# endif

# else

# if !defined(UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS)

# define UNITY_TRANSFER_SHADOW(a, coord)

# else

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# endif

# if (defined(SHADOWS_DEPTH) || defined(SHADOWS_SCREEN) || defined(SHADOWS_CUBE))

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# if UNITY_LIGHT_PROBE_PROXY_VOLUME

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, 0, 0)

# endif

# endif

# endif

#endifいろいろと分岐がありますがUNITY_SHADOW_COORDS(idx1)については

次の二択のようです。

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)# define UNITY_SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;SHADOW_COORDS(idx1)の定義についてはAutoLight.cgincにて次のとおりです。

#if defined (SHADOWS_SCREEN)

...

#define SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

...

#endif// -----------------------------

// Light/Shadow helpers (4.x version)

// -----------------------------

// This version computes light coordinates in the vertex shader and passes them to the fragment shader.

// ---- Spot light shadows

#if defined (SHADOWS_DEPTH) && defined (SPOT)

#define SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

...

#endif

// ---- Point light shadows

#if defined (SHADOWS_CUBE)

#define SHADOW_COORDS(idx1) unityShadowCoord3 _ShadowCoord : TEXCOORD##idx1;

...

#endif

// ---- Shadows off

#if !defined (SHADOWS_SCREEN) && !defined (SHADOWS_DEPTH) && !defined (SHADOWS_CUBE)

#define SHADOW_COORDS(idx1)

...

#endifUNITY_SHADOW_COORDS(idx1)はunityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;もしくはunityShadowCoord3 _ShadowCoord : TEXCOORD##idx1;もしくは空に展開されるということになります。

unityShadowCoord4はUnityShadowLibrary.cgincで次のように定義されています。

#define unityShadowCoord4 float4unityShadowCoord3はUnityShadowLibrary.cgincで次のように定義されています。

#define unityShadowCoord3 float3UNITY_SHADOW_COORDS(idx1)はシャドウがオフでない場合にv2fにfloat3かfloat4の_ShadowCoordを定義するものということになります。

頂点シェーダに追加したマクロ

頂点シェーダに追加したマクロについて見ていきます。

まず最初にUNITY_INITIALIZE_OUTPUT(v2f, o);を見ていきます。

HLSLSupport.cgincで次のように定義されています。

// Initialize arbitrary structure with zero values.

// Not supported on some backends (e.g. Cg-based particularly with nested structs).

// hlsl2glsl would almost support it, except with structs that have arrays -- so treat as not supported there either :(

#if defined(UNITY_COMPILER_HLSL) || defined(SHADER_API_PSSL) || defined(UNITY_COMPILER_HLSLCC)

#define UNITY_INITIALIZE_OUTPUT(type,name) name = (type)0;

#else

#define UNITY_INITIALIZE_OUTPUT(type,name)

#endifv2f型のoを初期化するものです。

次にUNITY_TRANSFER_LIGHTING(o,v.texcoord1.xy);を見ていきます。

UNITY_TRANSFER_LIGHTING(o,v.texcoord1.xy);AutoLight.cgincで次のように定義されています。

#define UNITY_TRANSFER_LIGHTING(a, coord) COMPUTE_LIGHT_COORDS(a) UNITY_TRANSFER_SHADOW(a, coord)COMPUTE_LIGHT_COORDS(a)とUNITY_TRANSFER_SHADOW(a, coord)を

並べたものに展開されます。

COMPUTE_LIGHT_COORDSの定義は次のとおりです。

#ifdef POINT

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord3 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xyz;

# define LIGHT_ATTENUATION(a) (tex2D(_LightTexture0, dot(a._LightCoord,a._LightCoord).rr).r * SHADOW_ATTENUATION(a))

#endif

#ifdef SPOT

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord4 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex));

# define LIGHT_ATTENUATION(a) ( (a._LightCoord.z > 0) * UnitySpotCookie(a._LightCoord) * UnitySpotAttenuate(a._LightCoord.xyz) * SHADOW_ATTENUATION(a) )

#endif

#ifdef DIRECTIONAL

# define DECLARE_LIGHT_COORDS(idx)

# define COMPUTE_LIGHT_COORDS(a)

# define LIGHT_ATTENUATION(a) SHADOW_ATTENUATION(a)

#endif

#ifdef POINT_COOKIE

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord3 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xyz;

# define LIGHT_ATTENUATION(a) (tex2D(_LightTextureB0, dot(a._LightCoord,a._LightCoord).rr).r * texCUBE(_LightTexture0, a._LightCoord).w * SHADOW_ATTENUATION(a))

#endif

#ifdef DIRECTIONAL_COOKIE

# define DECLARE_LIGHT_COORDS(idx) unityShadowCoord2 _LightCoord : TEXCOORD##idx;

# define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xy;

# define LIGHT_ATTENUATION(a) (tex2D(_LightTexture0, a._LightCoord).w * SHADOW_ATTENUATION(a))

#endifDIRECTIONALの場合は空です。

DIRECTIONALの場合UNITY_TRANSFER_LIGHTING(o,v.texcoord1.xy);は

UNITY_TRANSFER_SHADOW(a, coord)に展開されることになります。

UNITY_TRANSFER_SHADOW(a, coord)については

AutoLight.cgincで次のとおり定義されています。

#if defined(HANDLE_SHADOWS_BLENDING_IN_GI) // handles shadows in the depths of the GI function for performance reasons

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) SHADOW_ATTENUATION(a)

#elif defined(SHADOWS_SCREEN) && !defined(LIGHTMAP_ON) && !defined(UNITY_NO_SCREENSPACE_SHADOWS) // no lightmap uv thus store screenPos instead

// can happen if we have two directional lights. main light gets handled in GI code, but 2nd dir light can have shadow screen and mask.

// - Disabled on ES2 because WebGL 1.0 seems to have junk in .w (even though it shouldn't)

# if defined(SHADOWS_SHADOWMASK) && !defined(SHADER_API_GLES)

# define UNITY_SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

# define UNITY_TRANSFER_SHADOW(a, coord) {a._ShadowCoord.xy = coord * unity_LightmapST.xy + unity_LightmapST.zw; a._ShadowCoord.zw = ComputeScreenPos(a.pos).xy;}

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, worldPos, float4(a._ShadowCoord.zw, 0.0, UNITY_SHADOW_W(a.pos.w)));

# else

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, a._ShadowCoord)

# endif

#else

# define UNITY_SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

# if defined(SHADOWS_SHADOWMASK)

# define UNITY_TRANSFER_SHADOW(a, coord) a._ShadowCoord.xy = coord.xy * unity_LightmapST.xy + unity_LightmapST.zw;

# if (defined(SHADOWS_DEPTH) || defined(SHADOWS_SCREEN) || defined(SHADOWS_CUBE) || UNITY_LIGHT_PROBE_PROXY_VOLUME)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, 0, 0)

# endif

# else

# if !defined(UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS)

# define UNITY_TRANSFER_SHADOW(a, coord)

# else

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# endif

# if (defined(SHADOWS_DEPTH) || defined(SHADOWS_SCREEN) || defined(SHADOWS_CUBE))

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# if UNITY_LIGHT_PROBE_PROXY_VOLUME

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, 0, 0)

# endif

# endif

# endif

#endifこれについては後でフラグメントシェーダとまとめて見ていきます。

フラグメントシェーダに追加したマクロ

次にフラグメントシェーダで使われているマクロについて見てみます。

UNITY_LIGHT_ATTENUATION(attenuation, i, i.worldPos);について。

平行光源の場合はAutoLight.cgincで次のように定義されています。

#ifdef DIRECTIONAL

# define UNITY_LIGHT_ATTENUATION(destName, input, worldPos) fixed destName = UNITY_SHADOW_ATTENUATION(input, worldPos);

#endifUNITY_SHADOW_ATTENUATIONの結果をfixedで定義したdestNameに代入しています。

UNITY_SHADOW_ATTENUATIONの定義は先ほどと同じ場所で次のとおり定義されています。

#if defined(HANDLE_SHADOWS_BLENDING_IN_GI) // handles shadows in the depths of the GI function for performance reasons

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) SHADOW_ATTENUATION(a)

#elif defined(SHADOWS_SCREEN) && !defined(LIGHTMAP_ON) && !defined(UNITY_NO_SCREENSPACE_SHADOWS) // no lightmap uv thus store screenPos instead

// can happen if we have two directional lights. main light gets handled in GI code, but 2nd dir light can have shadow screen and mask.

// - Disabled on ES2 because WebGL 1.0 seems to have junk in .w (even though it shouldn't)

# if defined(SHADOWS_SHADOWMASK) && !defined(SHADER_API_GLES)

# define UNITY_SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

# define UNITY_TRANSFER_SHADOW(a, coord) {a._ShadowCoord.xy = coord * unity_LightmapST.xy + unity_LightmapST.zw; a._ShadowCoord.zw = ComputeScreenPos(a.pos).xy;}

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, worldPos, float4(a._ShadowCoord.zw, 0.0, UNITY_SHADOW_W(a.pos.w)));

# else

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, a._ShadowCoord)

# endif

#else

# define UNITY_SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

# if defined(SHADOWS_SHADOWMASK)

# define UNITY_TRANSFER_SHADOW(a, coord) a._ShadowCoord.xy = coord.xy * unity_LightmapST.xy + unity_LightmapST.zw;

# if (defined(SHADOWS_DEPTH) || defined(SHADOWS_SCREEN) || defined(SHADOWS_CUBE) || UNITY_LIGHT_PROBE_PROXY_VOLUME)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(a._ShadowCoord.xy, 0, 0)

# endif

# else

# if !defined(UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS)

# define UNITY_TRANSFER_SHADOW(a, coord)

# else

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# endif

# if (defined(SHADOWS_DEPTH) || defined(SHADOWS_SCREEN) || defined(SHADOWS_CUBE))

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# if UNITY_LIGHT_PROBE_PROXY_VOLUME

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, worldPos, UNITY_READ_SHADOW_COORDS(a))

# else

# define UNITY_SHADOW_ATTENUATION(a, worldPos) UnityComputeForwardShadows(0, 0, 0)

# endif

# endif

# endif

#endifこの部分のコードについて詳しく見ていきます。

#if defined(HANDLE_SHADOWS_BLENDING_IN_GI)のとき

まずは最初の分岐から見ていきます。

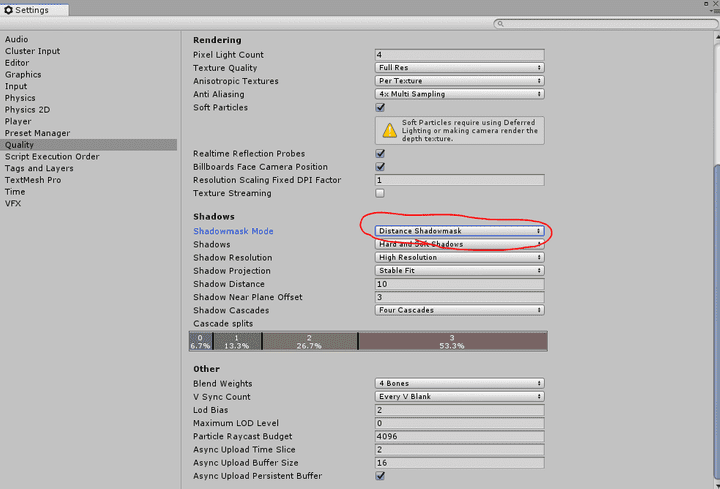

HANDLE_SHADOWS_BLENDING_IN_GIについて

最初の分岐はHANDLE_SHADOWS_BLENDING_IN_GIが定義されているかどうかで決まります。

HANDLE_SHADOWS_BLENDING_IN_GIはUnityShadowLibrary.cgincで

次のように定義されています。

#if defined( SHADOWS_SCREEN ) && defined( LIGHTMAP_ON )

#define HANDLE_SHADOWS_BLENDING_IN_GI 1

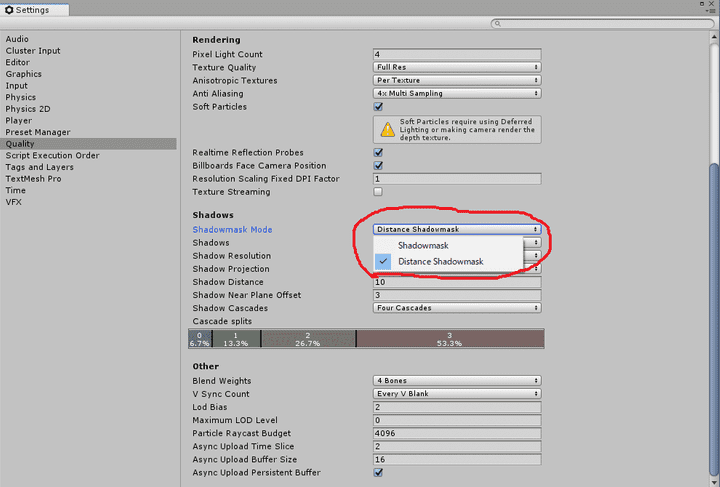

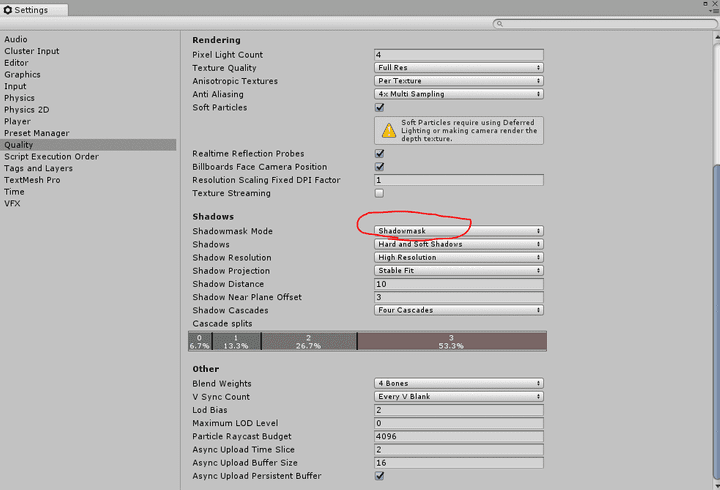

#endifSHADOWS_SCREENとLIGHTMAP_ONは実行時に渡されるキーワードのようです。

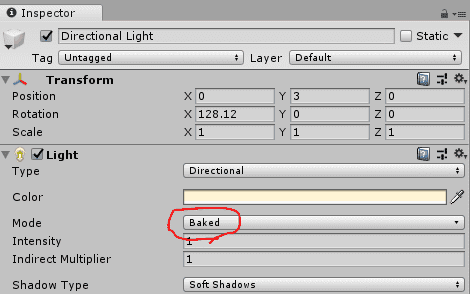

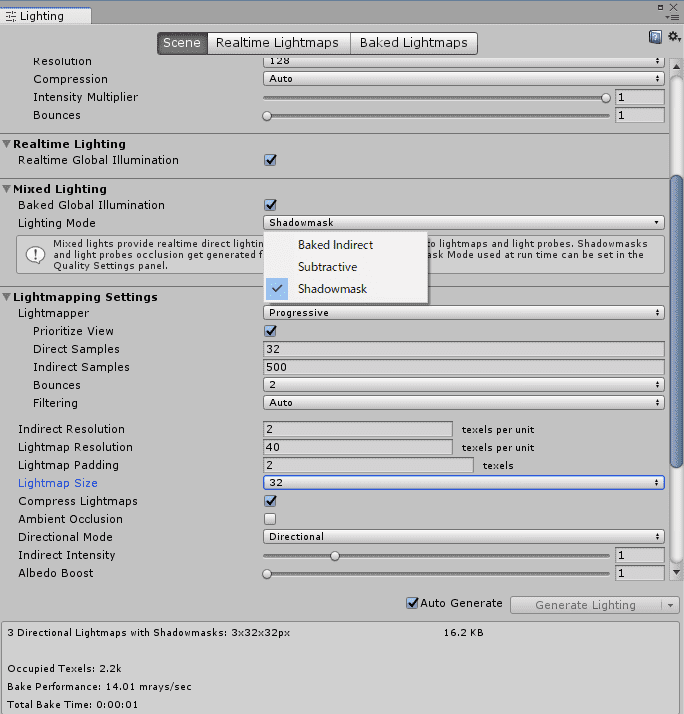

いくつか試して確認してみます。

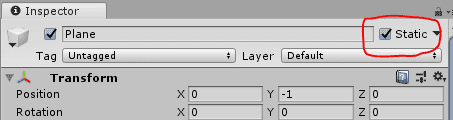

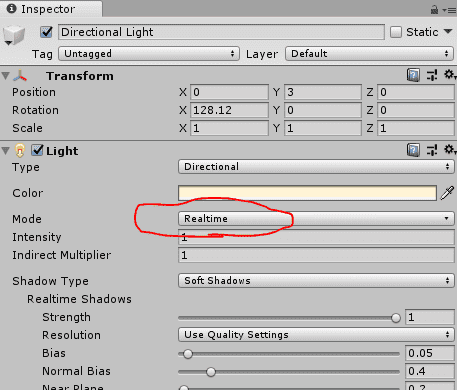

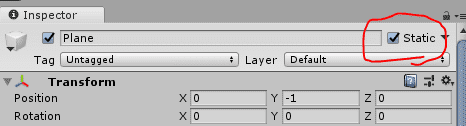

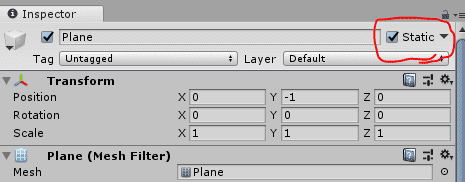

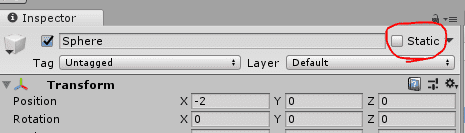

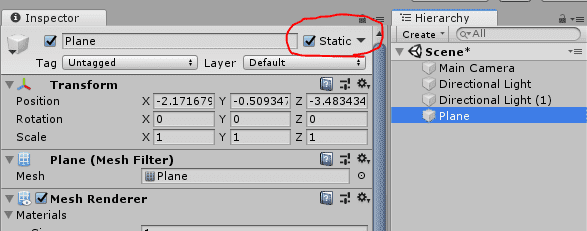

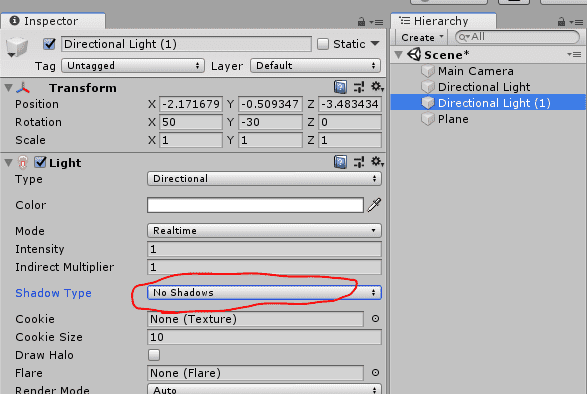

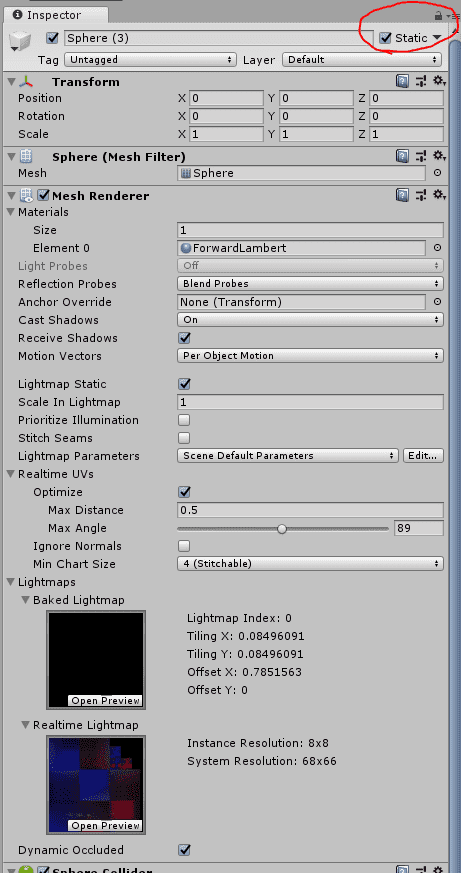

オブジェクトの「Static」をオフにしてライトの「Type」を「Realtime」にすると

SHADOWS_SCREENが追加されました。

オブジェクトを「Static」にしてライトの「Type」を「Realtime」にすると

SHADOWS_SCREENとLIGHTMAP_ONが両方追加されました。

オブジェクトを「Static」にしてライトの「Type」を「Baked」にすると

LIGHTMAP_ONが追加されました。

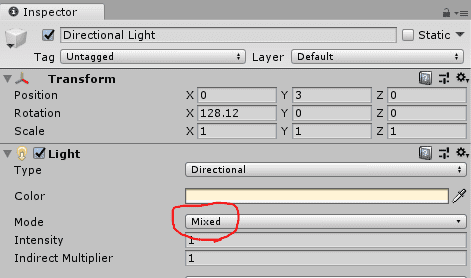

オブジェクトを「Static」にしてライトの「Type」を「Mixed」にすると

SHADOWS_SCREENとLIGHTMAP_ONが両方追加されました。

オブジェクトが「Static」ではない場合、ライトが「Mixed」でもSHADOWS_SCREENのみです。

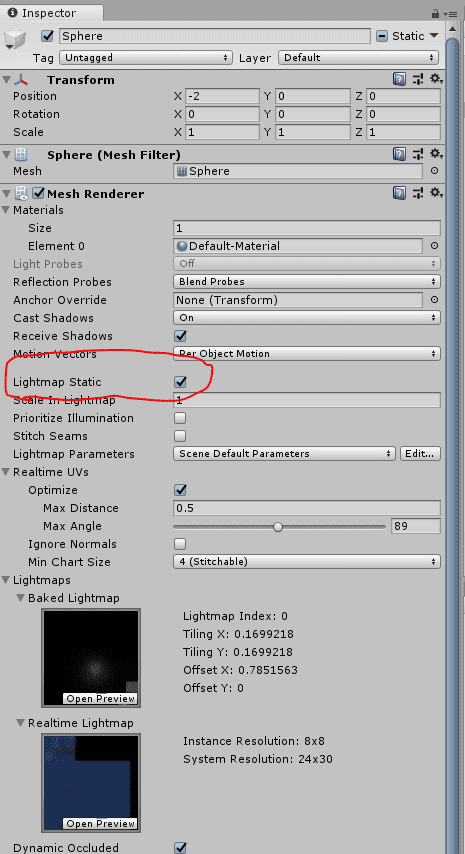

ただし「Lightmap Static」をオンにするとLIGHTMAP_ONがオンになりました。

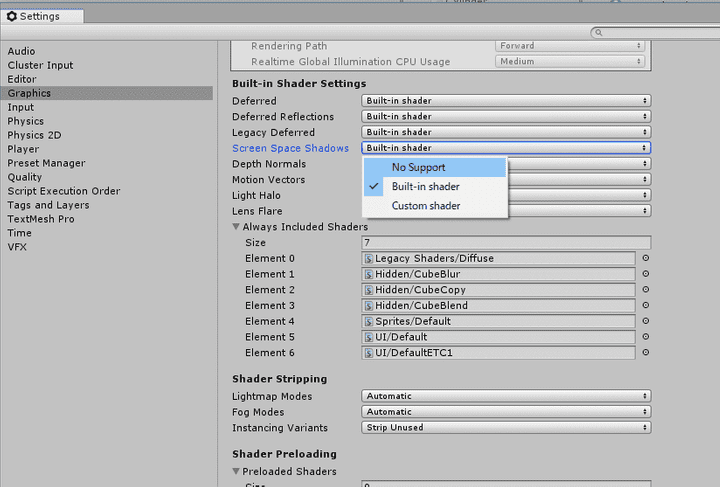

設定の「Graphics」から「Screen Space Shadows」を「No Support」にすると

上記の「SHADOWS_SCREEN」が追加されていた場合でも追加されなくなりました。

ただし、この場合はリアルタイムの影が描画されないようです。

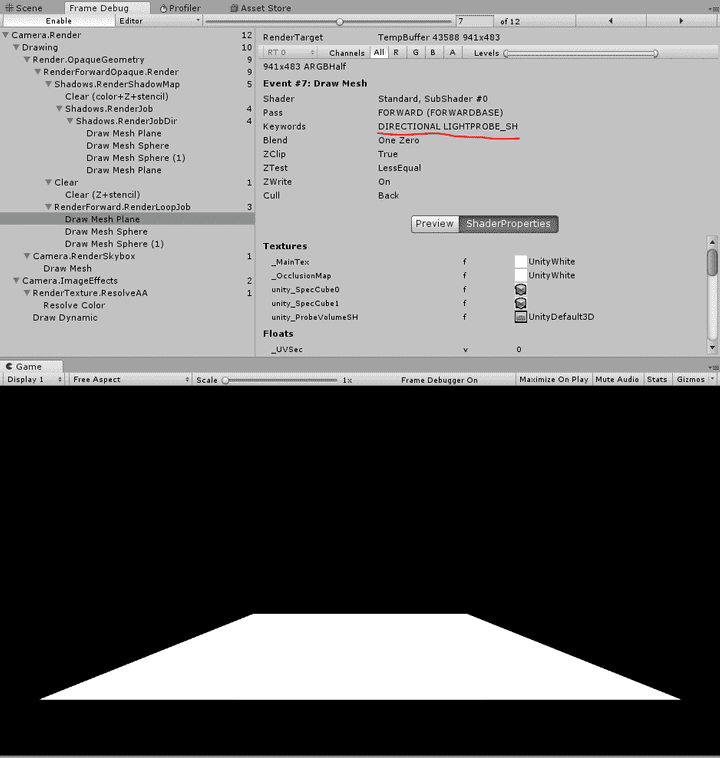

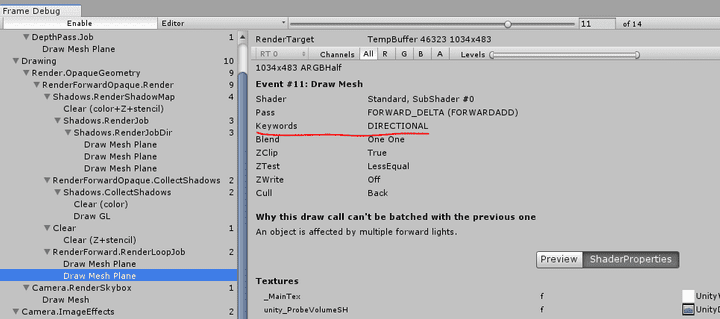

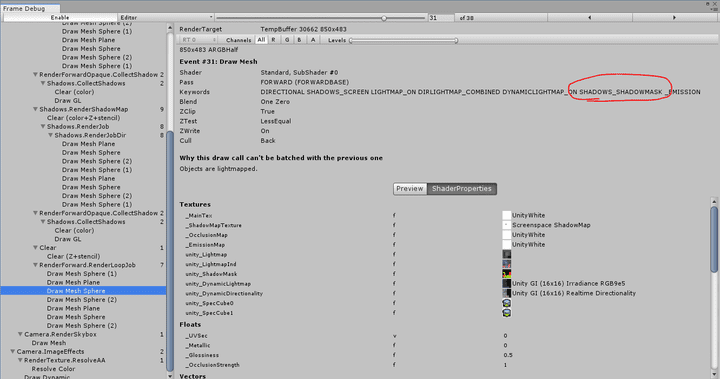

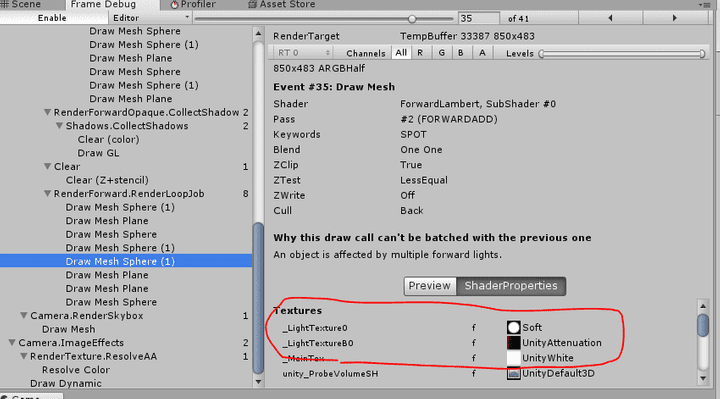

ついでに加算パスの場合の挙動についても確認しておきます。

平行光源を2つおいてみました。

2つ目の平行光源でも影を有効にします。

Staticなオブジェクトを配置します。

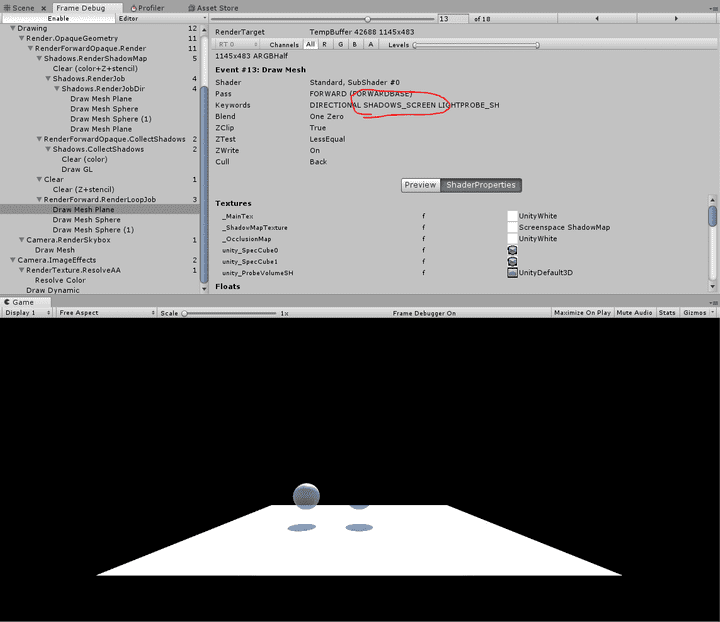

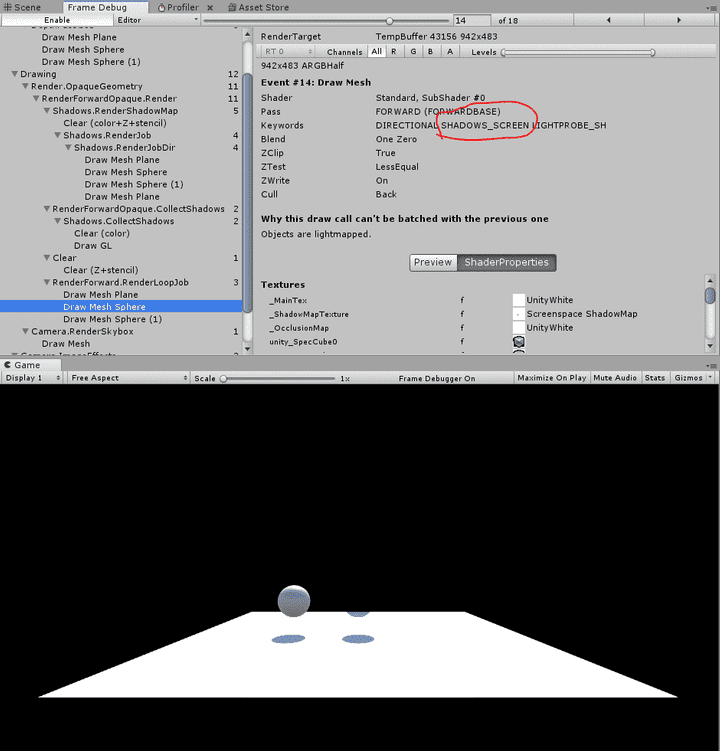

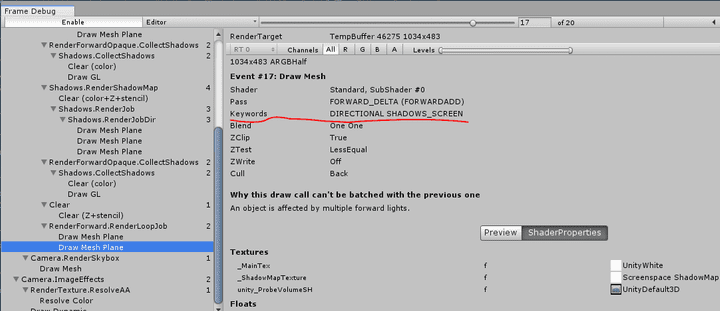

ベースパスの場合は次のとおりです。

加算パスは次のようになっていました。

たとえStaticなオブジェクトであっても

LIGHTMAP_ONが加算パスには追加されていないことがわかります。

確かにベースパスと加算パスの両方でライトマップを扱ってしまうと

多重にライトマップが適用されることになってしまいますね。

2つ目の平行光源の影を無効にした場合は次のようになりました。

この場合はリアルタイムの影の描画を行わないので

SHADOWS_SCREENも追加されていないことがわかります。

まとめると次のようになります。

設定を弄らない限り、デスクトップ上では

ライトが「Realtime」や「Mixed」でリアルタイムの影が描画される場合は

SHADOWS_SCREENが追加されます。

Staticなオブジェクトなどのライトマップが作成される場合はLIGHTMAP_ONが追加されます。

両方の条件が重なる「Realtime」や「Mixed」でStaticなオブジェクトの場合には

両方が追加されます。

また、加算パスの場合はたとえStaticなオブジェクトであってもLIGHTMAP_ONが追加されません。

HANDLE_SHADOWS_BLENDING_IN_GIはリアルタイムの影がオンでかつライトマップがオンの場合

オンになるようです。

Surface Shaderから生成したコードでもHANDLE_SHADOWS_BLENDING_IN_GIを

利用している箇所があります。

Surface Shaderから生成したコードのフラグメントシェーダでLightingStandard_GI(o, giInput, gi);を呼び出しています。

このLightingStandard_GIの内部でUnityGI_Baseという関数を呼び出しています。

UnityGI_BaseはUnityGlobalIllumination.cgincで次のように定義されています。

inline UnityGI UnityGI_Base(UnityGIInput data, half occlusion, half3 normalWorld)

{

UnityGI o_gi;

ResetUnityGI(o_gi);

// Base pass with Lightmap support is responsible for handling ShadowMask / blending here for performance reason

#if defined(HANDLE_SHADOWS_BLENDING_IN_GI)

half bakedAtten = UnitySampleBakedOcclusion(data.lightmapUV.xy, data.worldPos);

float zDist = dot(_WorldSpaceCameraPos - data.worldPos, UNITY_MATRIX_V[2].xyz);

float fadeDist = UnityComputeShadowFadeDistance(data.worldPos, zDist);

data.atten = UnityMixRealtimeAndBakedShadows(data.atten, bakedAtten, UnityComputeShadowFade(fadeDist));

#endif

o_gi.light = data.light;

o_gi.light.color *= data.atten;

#if UNITY_SHOULD_SAMPLE_SH

o_gi.indirect.diffuse = ShadeSHPerPixel(normalWorld, data.ambient, data.worldPos);

#endif

#if defined(LIGHTMAP_ON)

// Baked lightmaps

half4 bakedColorTex = UNITY_SAMPLE_TEX2D(unity_Lightmap, data.lightmapUV.xy);

half3 bakedColor = DecodeLightmap(bakedColorTex);

#ifdef DIRLIGHTMAP_COMBINED

fixed4 bakedDirTex = UNITY_SAMPLE_TEX2D_SAMPLER (unity_LightmapInd, unity_Lightmap, data.lightmapUV.xy);

o_gi.indirect.diffuse += DecodeDirectionalLightmap (bakedColor, bakedDirTex, normalWorld);

#if defined(LIGHTMAP_SHADOW_MIXING) && !defined(SHADOWS_SHADOWMASK) && defined(SHADOWS_SCREEN)

ResetUnityLight(o_gi.light);

o_gi.indirect.diffuse = SubtractMainLightWithRealtimeAttenuationFromLightmap (o_gi.indirect.diffuse, data.atten, bakedColorTex, normalWorld);

#endif

#else // not directional lightmap

o_gi.indirect.diffuse += bakedColor;

#if defined(LIGHTMAP_SHADOW_MIXING) && !defined(SHADOWS_SHADOWMASK) && defined(SHADOWS_SCREEN)

ResetUnityLight(o_gi.light);

o_gi.indirect.diffuse = SubtractMainLightWithRealtimeAttenuationFromLightmap(o_gi.indirect.diffuse, data.atten, bakedColorTex, normalWorld);

#endif

#endif

#endif

#ifdef DYNAMICLIGHTMAP_ON

// Dynamic lightmaps

fixed4 realtimeColorTex = UNITY_SAMPLE_TEX2D(unity_DynamicLightmap, data.lightmapUV.zw);

half3 realtimeColor = DecodeRealtimeLightmap (realtimeColorTex);

#ifdef DIRLIGHTMAP_COMBINED

half4 realtimeDirTex = UNITY_SAMPLE_TEX2D_SAMPLER(unity_DynamicDirectionality, unity_DynamicLightmap, data.lightmapUV.zw);

o_gi.indirect.diffuse += DecodeDirectionalLightmap (realtimeColor, realtimeDirTex, normalWorld);

#else

o_gi.indirect.diffuse += realtimeColor;

#endif

#endif

o_gi.indirect.diffuse *= occlusion;

return o_gi;

}最初の部分でHANDLE_SHADOWS_BLENDING_IN_GIを利用しています。

// Base pass with Lightmap support is responsible for handling ShadowMask / blending here for performance reason

#if defined(HANDLE_SHADOWS_BLENDING_IN_GI)

half bakedAtten = UnitySampleBakedOcclusion(data.lightmapUV.xy, data.worldPos);

float zDist = dot(_WorldSpaceCameraPos - data.worldPos, UNITY_MATRIX_V[2].xyz);

float fadeDist = UnityComputeShadowFadeDistance(data.worldPos, zDist);

data.atten = UnityMixRealtimeAndBakedShadows(data.atten, bakedAtten, UnityComputeShadowFade(fadeDist));

#endifリアルタイムシャドウのフェードを計算し、 ベイクされたシャドウとリアルタイムのシャドウのブレンドの計算をここで行っているようです。

その分、UNITY_SHADOW_ATTENUATIONなどの処理は

フェード処理を省いた簡略化したものになっています。

HANDLE_SHADOWS_BLENDING_IN_GIのとき

HANDLE_SHADOWS_BLENDING_IN_GIが定義されている場合には、

最初の分岐に入って次の処理が行われます。

#if defined(HANDLE_SHADOWS_BLENDING_IN_GI) // handles shadows in the depths of the GI function for performance reasons

# define UNITY_SHADOW_COORDS(idx1) SHADOW_COORDS(idx1)

# define UNITY_TRANSFER_SHADOW(a, coord) TRANSFER_SHADOW(a)

# define UNITY_SHADOW_ATTENUATION(a, worldPos) SHADOW_ATTENUATION(a)

#elifUNITY_SHADOW_COORDS(idx1)と

UNITY_TRANSFER_SHADOW(a, coord)、

UNITY_SHADOW_ATTENUATION(a, worldPos)は

それぞれSHADOW_COORDS(idx1)とTRANSFER_SHADOW(a)、

SHADOW_ATTENUATION(a)に展開されます。

定義は次のとおりです。

// ---- Screen space direction light shadows helpers (any version)

#if defined (SHADOWS_SCREEN)

#if defined(UNITY_NO_SCREENSPACE_SHADOWS)

UNITY_DECLARE_SHADOWMAP(_ShadowMapTexture);

#define TRANSFER_SHADOW(a) a._ShadowCoord = mul( unity_WorldToShadow[0], mul( unity_ObjectToWorld, v.vertex ) );

inline fixed unitySampleShadow (unityShadowCoord4 shadowCoord)

{

#if defined(SHADOWS_NATIVE)

fixed shadow = UNITY_SAMPLE_SHADOW(_ShadowMapTexture, shadowCoord.xyz);

shadow = _LightShadowData.r + shadow * (1-_LightShadowData.r);

return shadow;

#else

unityShadowCoord dist = SAMPLE_DEPTH_TEXTURE(_ShadowMapTexture, shadowCoord.xy);

// tegra is confused if we use _LightShadowData.x directly

// with "ambiguous overloaded function reference max(mediump float, float)"

unityShadowCoord lightShadowDataX = _LightShadowData.x;

unityShadowCoord threshold = shadowCoord.z;

return max(dist > threshold, lightShadowDataX);

#endif

}

#else // UNITY_NO_SCREENSPACE_SHADOWS

UNITY_DECLARE_SCREENSPACE_SHADOWMAP(_ShadowMapTexture);

#define TRANSFER_SHADOW(a) a._ShadowCoord = ComputeScreenPos(a.pos);

inline fixed unitySampleShadow (unityShadowCoord4 shadowCoord)

{

fixed shadow = UNITY_SAMPLE_SCREEN_SHADOW(_ShadowMapTexture, shadowCoord);

return shadow;

}

#endif

#define SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

#define SHADOW_ATTENUATION(a) unitySampleShadow(a._ShadowCoord)

#endif// -----------------------------

// Light/Shadow helpers (4.x version)

// -----------------------------

// This version computes light coordinates in the vertex shader and passes them to the fragment shader.

// ---- Spot light shadows

#if defined (SHADOWS_DEPTH) && defined (SPOT)

#define SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;

#define TRANSFER_SHADOW(a) a._ShadowCoord = mul (unity_WorldToShadow[0], mul(unity_ObjectToWorld,v.vertex));

#define SHADOW_ATTENUATION(a) UnitySampleShadowmap(a._ShadowCoord)

#endif

// ---- Point light shadows

#if defined (SHADOWS_CUBE)

#define SHADOW_COORDS(idx1) unityShadowCoord3 _ShadowCoord : TEXCOORD##idx1;

#define TRANSFER_SHADOW(a) a._ShadowCoord.xyz = mul(unity_ObjectToWorld, v.vertex).xyz - _LightPositionRange.xyz;

#define SHADOW_ATTENUATION(a) UnitySampleShadowmap(a._ShadowCoord)

#define READ_SHADOW_COORDS(a) unityShadowCoord4(a._ShadowCoord.xyz, 1.0)

#endif

// ---- Shadows off

#if !defined (SHADOWS_SCREEN) && !defined (SHADOWS_DEPTH) && !defined (SHADOWS_CUBE)

#define SHADOW_COORDS(idx1)

#define TRANSFER_SHADOW(a)

#define SHADOW_ATTENUATION(a) 1.0

#define READ_SHADOW_COORDS(a) 0

#else

#ifndef READ_SHADOW_COORDS

#define READ_SHADOW_COORDS(a) a._ShadowCoord

#endif

#endifHANDLE_SHADOWS_BLENDING_IN_GIが定義されている場合は

SHADOWS_SCREENが定義されているので最初の方になるようですね。

2つ目の方は気にしなくて良さそうです。

さきほども見ましたが、

SHADOW_COORDS(idx1)の定義を抜き出すと次のとおりです。

#define SHADOW_COORDS(idx1) unityShadowCoord4 _ShadowCoord : TEXCOORD##idx1;与えられた番号のTEXCORRDで_ShadowCoordをv2f構造体に定義するようです。

unityShadowCoord4はUnityShadowLibrary.cdgincで次のように定義されています。

#define unityShadowCoord4 float4TRANSFER_SHADOW(a)とSHADOW_ATTENUATION(a)は

UNITY_NO_SCREENSPACE_SHADOWSで分岐がなされているようです。

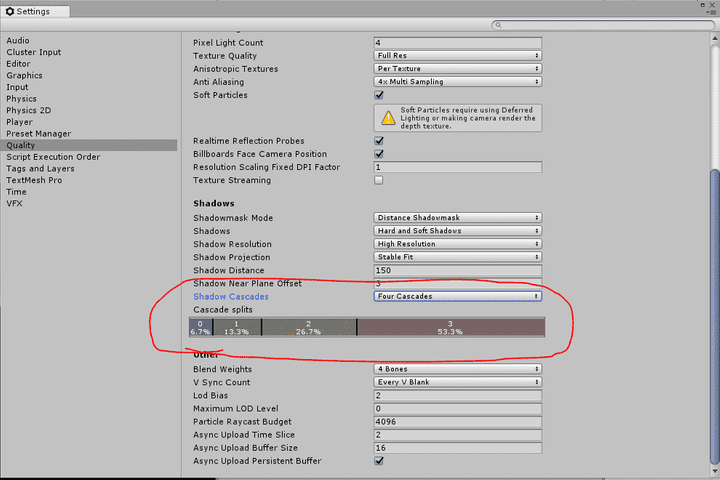

UNITY_NO_SCREENSPACE_SHADOWSについては次のページに載っています。

UNITYNOSCREENSPACE_SHADOWS : Defined on platforms that do not use cascaded screenspace shadowmaps (mobile platforms).

モバイルの場合はUNITY_NO_SCREENSPACE_SHADOWSが定義されるようですね。

順に見ていくことにします。

モバイルの場合は次のようになります。

UNITY_DECLARE_SHADOWMAP(_ShadowMapTexture);

#define TRANSFER_SHADOW(a) a._ShadowCoord = mul( unity_WorldToShadow[0], mul( unity_ObjectToWorld, v.vertex ) );

inline fixed unitySampleShadow (unityShadowCoord4 shadowCoord)

{

#if defined(SHADOWS_NATIVE)

fixed shadow = UNITY_SAMPLE_SHADOW(_ShadowMapTexture, shadowCoord.xyz);

shadow = _LightShadowData.r + shadow * (1-_LightShadowData.r);

return shadow;

#else

unityShadowCoord dist = SAMPLE_DEPTH_TEXTURE(_ShadowMapTexture, shadowCoord.xy);

// tegra is confused if we use _LightShadowData.x directly

// with "ambiguous overloaded function reference max(mediump float, float)"

unityShadowCoord lightShadowDataX = _LightShadowData.x;

unityShadowCoord threshold = shadowCoord.z;

return max(dist > threshold, lightShadowDataX);

#endif

}

#define SHADOW_ATTENUATION(a) unitySampleShadow(a._ShadowCoord)最初にUNITY_DECLARE_SHADOWMAP(_ShadowMapTexture);で

シャドウマップテクスチャを定義しています。

UNITY_DECLARE_SHADOWMAP(_ShadowMapTexture);はHLSLSupport.cgincで定義されていて、

プラットフォームに合わせてテクスチャとシャドウ用のサンプラーの定義をしているようです。

UNITY_DECLARE_SHADOWMAP(_ShadowMapTexture);の定義の付近を次に抜き出します。

// Macros to declare and sample shadow maps.

//

// UNITY_DECLARE_SHADOWMAP declares a shadowmap.

// UNITY_SAMPLE_SHADOW samples with a float3 coordinate (UV in xy, Z in z) and returns 0..1 scalar result.

// UNITY_SAMPLE_SHADOW_PROJ samples with a projected coordinate (UV and Z divided by w).

#if !defined(SHADER_API_GLES)

// all platforms except GLES2.0 have built-in shadow comparison samplers

#define SHADOWS_NATIVE

#elif defined(SHADER_API_GLES) && defined(UNITY_ENABLE_NATIVE_SHADOW_LOOKUPS)

// GLES2.0 also has built-in shadow comparison samplers, but only on platforms where we pass UNITY_ENABLE_NATIVE_SHADOW_LOOKUPS from the editor

#define SHADOWS_NATIVE

#endif

#if defined(SHADER_API_D3D11) || (defined(UNITY_COMPILER_HLSLCC) && defined(SHADOWS_NATIVE))

// DX11 & hlslcc platforms: built-in PCF

#define UNITY_DECLARE_SHADOWMAP(tex) Texture2D tex; SamplerComparisonState sampler##tex

#define UNITY_DECLARE_TEXCUBE_SHADOWMAP(tex) TextureCube tex; SamplerComparisonState sampler##tex

#define UNITY_SAMPLE_SHADOW(tex,coord) tex.SampleCmpLevelZero (sampler##tex,(coord).xy,(coord).z)

#define UNITY_SAMPLE_SHADOW_PROJ(tex,coord) tex.SampleCmpLevelZero (sampler##tex,(coord).xy/(coord).w,(coord).z/(coord).w)

#if defined(SHADER_API_GLCORE) || defined(SHADER_API_GLES3) || defined(SHADER_API_VULKAN) || defined(SHADER_API_SWITCH)

// GLSL does not have textureLod(samplerCubeShadow, ...) support. GLES2 does not have core support for samplerCubeShadow, so we ignore it.

#define UNITY_SAMPLE_TEXCUBE_SHADOW(tex,coord) tex.SampleCmp (sampler##tex,(coord).xyz,(coord).w)

#else

#define UNITY_SAMPLE_TEXCUBE_SHADOW(tex,coord) tex.SampleCmpLevelZero (sampler##tex,(coord).xyz,(coord).w)

#endif

#elif defined(UNITY_COMPILER_HLSL2GLSL) && defined(SHADOWS_NATIVE)

// OpenGL-like hlsl2glsl platforms: most of them always have built-in PCF

#define UNITY_DECLARE_SHADOWMAP(tex) sampler2DShadow tex

#define UNITY_DECLARE_TEXCUBE_SHADOWMAP(tex) samplerCUBEShadow tex

#define UNITY_SAMPLE_SHADOW(tex,coord) shadow2D (tex,(coord).xyz)

#define UNITY_SAMPLE_SHADOW_PROJ(tex,coord) shadow2Dproj (tex,coord)

#define UNITY_SAMPLE_TEXCUBE_SHADOW(tex,coord) ((texCUBE(tex,(coord).xyz) < (coord).w) ? 0.0 : 1.0)

#elif defined(SHADER_API_PSSL)

// PS4: built-in PCF

#define UNITY_DECLARE_SHADOWMAP(tex) Texture2D tex; SamplerComparisonState sampler##tex

#define UNITY_DECLARE_TEXCUBE_SHADOWMAP(tex) TextureCube tex; SamplerComparisonState sampler##tex

#define UNITY_SAMPLE_SHADOW(tex,coord) tex.SampleCmpLOD0(sampler##tex,(coord).xy,(coord).z)

#define UNITY_SAMPLE_SHADOW_PROJ(tex,coord) tex.SampleCmpLOD0(sampler##tex,(coord).xy/(coord).w,(coord).z/(coord).w)

#define UNITY_SAMPLE_TEXCUBE_SHADOW(tex,coord) tex.SampleCmpLOD0(sampler##tex,(coord).xyz,(coord).w)

#else

// Fallback / No built-in shadowmap comparison sampling: regular texture sample and do manual depth comparison

#define UNITY_DECLARE_SHADOWMAP(tex) sampler2D_float tex

#define UNITY_DECLARE_TEXCUBE_SHADOWMAP(tex) samplerCUBE_float tex

#define UNITY_SAMPLE_SHADOW(tex,coord) ((SAMPLE_DEPTH_TEXTURE(tex,(coord).xy) < (coord).z) ? 0.0 : 1.0)

#define UNITY_SAMPLE_SHADOW_PROJ(tex,coord) ((SAMPLE_DEPTH_TEXTURE_PROJ(tex,UNITY_PROJ_COORD(coord)) < ((coord).z/(coord).w)) ? 0.0 : 1.0)

#define UNITY_SAMPLE_TEXCUBE_SHADOW(tex,coord) ((SAMPLE_DEPTH_CUBE_TEXTURE(tex,(coord).xyz) < (coord).w) ? 0.0 : 1.0)

#endifプラットフォームごとに4パターンに分かれているようです。 シャドウの比較用のサンプラーがプラットフォームにある場合には それを使うようにしているようです。 後で使うサンプリングの方も一緒に定義されていますね。

たとえばD3D11の場合次のようになります。

#define UNITY_DECLARE_SHADOWMAP(tex) Texture2D tex; SamplerComparisonState sampler##tex

#define UNITY_SAMPLE_SHADOW(tex,coord) tex.SampleCmpLevelZero (sampler##tex,(coord).xy,(coord).z)tex.SampleCmpLevelZeroはSampleCmpのミップマップのレベルを0に固定したものです。

次のページに解説があります。

(coord).zと比較してパスした場合には1でそれ以外の場合には0になります。

このSampleCmpはPCFも計算してくれます。

PCFはPercentage Closer Filteringの略です。

シャドウマップはその比較して使うという特殊な用途から通常のフィルタリングがうまくいきません。

シャドウマップと比較した結果は結局0と1の2値として返されるためエイリアシングが除去できません。

PCFではフィルタリングの前に比較テストを行い、それからサンプリングします。

このためSampleCmpが使える環境では通常のサンプリングではなく

こちらを使ったほうが影の質がよくなるようです。

TRANSFER_SHADOW(a)ではunity_WorldToShadow[0]を使って頂点をシャドウ用に

変換しているようです。

unity_WorldToShadowには0から3まであって、それぞれ

カスケードに対応したシャドウ用の変換行列が入っているようなのですが

モバイルの場合は0固定でカスケードには対応していないということなのでしょうか。

#define TRANSFER_SHADOW(a) a._ShadowCoord = mul( unity_WorldToShadow[0], mul( unity_ObjectToWorld, v.vertex ) );SHADOW_ATTENUATION(a)は次のように定義されています。

#define SHADOW_ATTENUATION(a) unitySampleShadow(a._ShadowCoord)SHADOW_ATTENUATION(a)の実態のunitySampleShadow(a._ShadowCoord)では

SHADOWS_NATIVEの有無で処理がわかれています。

SHADOWS_NATIVEの場合は次のとおりです。

#if defined(SHADOWS_NATIVE)

fixed shadow = UNITY_SAMPLE_SHADOW(_ShadowMapTexture, shadowCoord.xyz);

shadow = _LightShadowData.r + shadow * (1-_LightShadowData.r);

return shadow;

#elseUNITY_SAMPLE_SHADOWは上で見たとおりです。

完全な影の場合0が、完全な日向の場合1が渡されます。

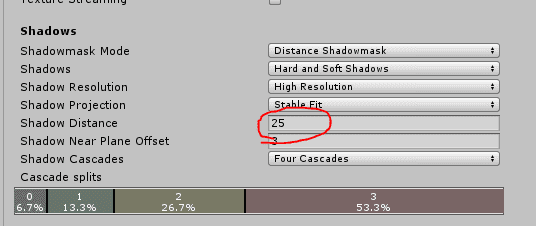

_LightShadowDataは次のページに情報がありました。

_LightShadowData.x - shadow strength

_LightShadowData.y - Appears to be unused

_LightShadowData.z - 1.0 / shadow far distance

_LightShadowData.w - shadow near distance_LightShadowData.rはシャドウの強さのようです。

シャドウの強さはエディタ上でライトの設定で行なえます。

shadow = _LightShadowData.r + shadow * (1-_LightShadowData.r);は

パッと見わかりにくいですが式変形すると次のようになります。

shadow = 1 - ((1 - shadow) * (1-_LightShadowData.r));この式を見る限り_LightShadowData.rは0でシャドウが最大で

1でシャドウが最小になっているようです。

エディタの値とは逆です。

サンプルしたシャドウの0から1の値にシャドウの強さを適用しています。

SHADOWS_NATIVEではない場合は次のとおりです。

#else

unityShadowCoord dist = SAMPLE_DEPTH_TEXTURE(_ShadowMapTexture, shadowCoord.xy);

// tegra is confused if we use _LightShadowData.x directly

// with "ambiguous overloaded function reference max(mediump float, float)"

unityShadowCoord lightShadowDataX = _LightShadowData.x;

unityShadowCoord threshold = shadowCoord.z;

return max(dist > threshold, lightShadowDataX);

#endifデプステクスチャからサンプリングして渡されたshadowCoordのzと比較しています。

シャドウマップが渡されたzより大きい場合1が、

そうでない場合には_LightShadowData.xが返されます。

_LightShadowData.rについては上で見たとおりシャドウの強さです。

0でシャドウが最大に、1でシャドウが最小になります。

影の場合はこれをそのまま返せばよいわけですね。

PCFを使わないため0と1の2値になっているので

SHADOWS_NATIVEのときとは違う計算になっています。

ここまでUNITY_NO_SCREENSPACE_SHADOWSが定義されているモバイルの場合でした。

モバイルではない場合は次のようになります。

UNITY_DECLARE_SCREENSPACE_SHADOWMAP(_ShadowMapTexture);

#define TRANSFER_SHADOW(a) a._ShadowCoord = ComputeScreenPos(a.pos);

inline fixed unitySampleShadow (unityShadowCoord4 shadowCoord)

{

fixed shadow = UNITY_SAMPLE_SCREEN_SHADOW(_ShadowMapTexture, shadowCoord);

return shadow;

}

#define SHADOW_ATTENUATION(a) unitySampleShadow(a._ShadowCoord)最初にUNITY_DECLARE_SCREENSPACE_SHADOWMAP(_ShadowMapTexture);で

スクリーンスペースのシャドウマップを定義しています。

UNITY_DECLARE_SCREENSPACE_SHADOWMAP(_ShadowMapTexture);はHLSLSupport.cgincで

次のように定義されています。

#if defined(UNITY_STEREO_INSTANCING_ENABLED) || defined(UNITY_STEREO_MULTIVIEW_ENABLED)

#undef UNITY_DECLARE_DEPTH_TEXTURE_MS

#define UNITY_DECLARE_DEPTH_TEXTURE_MS(tex) UNITY_DECLARE_TEX2DARRAY_MS (tex)

#undef UNITY_DECLARE_DEPTH_TEXTURE

#define UNITY_DECLARE_DEPTH_TEXTURE(tex) UNITY_DECLARE_TEX2DARRAY (tex)

#undef SAMPLE_DEPTH_TEXTURE

#define SAMPLE_DEPTH_TEXTURE(sampler, uv) UNITY_SAMPLE_TEX2DARRAY(sampler, float3((uv).x, (uv).y, (float)unity_StereoEyeIndex)).r

#undef SAMPLE_DEPTH_TEXTURE_PROJ

#define SAMPLE_DEPTH_TEXTURE_PROJ(sampler, uv) UNITY_SAMPLE_TEX2DARRAY(sampler, float3((uv).x/(uv).w, (uv).y/(uv).w, (float)unity_StereoEyeIndex)).r

#undef SAMPLE_DEPTH_TEXTURE_LOD

#define SAMPLE_DEPTH_TEXTURE_LOD(sampler, uv) UNITY_SAMPLE_TEX2DARRAY_LOD(sampler, float3((uv).xy, (float)unity_StereoEyeIndex), (uv).w).r

#undef SAMPLE_RAW_DEPTH_TEXTURE

#define SAMPLE_RAW_DEPTH_TEXTURE(tex, uv) UNITY_SAMPLE_TEX2DARRAY(tex, float3((uv).xy, (float)unity_StereoEyeIndex))

#undef SAMPLE_RAW_DEPTH_TEXTURE_PROJ

#define SAMPLE_RAW_DEPTH_TEXTURE_PROJ(sampler, uv) UNITY_SAMPLE_TEX2DARRAY(sampler, float3((uv).x/(uv).w, (uv).y/(uv).w, (float)unity_StereoEyeIndex))

#undef SAMPLE_RAW_DEPTH_TEXTURE_LOD

#define SAMPLE_RAW_DEPTH_TEXTURE_LOD(sampler, uv) UNITY_SAMPLE_TEX2DARRAY_LOD(sampler, float3((uv).xy, (float)unity_StereoEyeIndex), (uv).w)

#define UNITY_DECLARE_SCREENSPACE_SHADOWMAP UNITY_DECLARE_TEX2DARRAY

#define UNITY_SAMPLE_SCREEN_SHADOW(tex, uv) UNITY_SAMPLE_TEX2DARRAY( tex, float3((uv).x/(uv).w, (uv).y/(uv).w, (float)unity_StereoEyeIndex) ).r

#define UNITY_DECLARE_SCREENSPACE_TEXTURE UNITY_DECLARE_TEX2DARRAY

#define UNITY_SAMPLE_SCREENSPACE_TEXTURE(tex, uv) UNITY_SAMPLE_TEX2DARRAY(tex, float3((uv).xy, (float)unity_StereoEyeIndex))

#else

#define UNITY_DECLARE_DEPTH_TEXTURE_MS(tex) Texture2DMS<float> tex;

#define UNITY_DECLARE_DEPTH_TEXTURE(tex) sampler2D_float tex

#define UNITY_DECLARE_SCREENSPACE_SHADOWMAP(tex) sampler2D tex

#define UNITY_SAMPLE_SCREEN_SHADOW(tex, uv) tex2Dproj( tex, UNITY_PROJ_COORD(uv) ).r

#define UNITY_DECLARE_SCREENSPACE_TEXTURE(tex) sampler2D tex;

#define UNITY_SAMPLE_SCREENSPACE_TEXTURE(tex, uv) tex2D(tex, uv)

#endifVRなどの場合のステレオ描画に対応させているようです。

頂点シェーダのTRANSFER_SHADOW(a)では

_ShadowCoordにスクリーンスペースの位置を代入しています。

#define TRANSFER_SHADOW(a) a._ShadowCoord = ComputeScreenPos(a.pos);フラグメントシェーダのSHADOW_ATTENUATION(a)では

シャドウマップからサンプルしたシャドウを返しています。

inline fixed unitySampleShadow (unityShadowCoord4 shadowCoord)

{

fixed shadow = UNITY_SAMPLE_SCREEN_SHADOW(_ShadowMapTexture, shadowCoord);

return shadow;

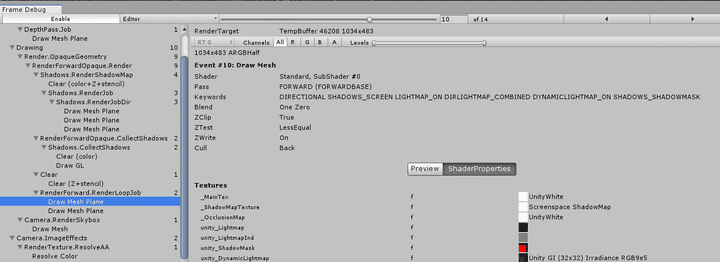

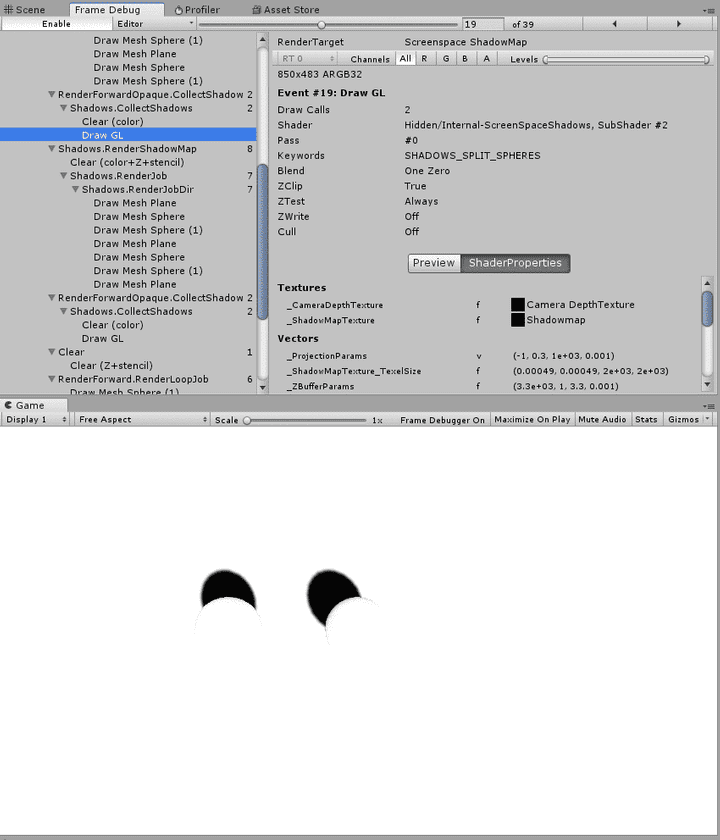

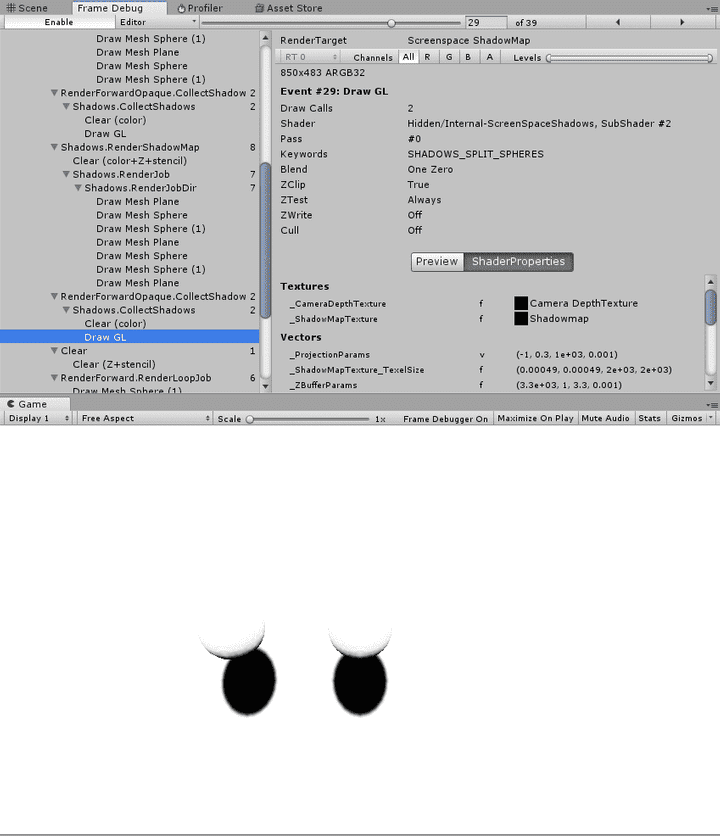

}フレームデバッガを見てみるとShadows.CollectShadowsというパスで スクリーンスペースのシャドウを作っているようです。

平行光源が複数ある場合はその分だけスクリーンスペースシャドウが作られます。

確かにこのスクリーンスペースのシャドウマップを利用すれば ただスクリーンスペースでサンプリングするだけで良さそうです。

スクリーンスペースシャドウ

それではスクリーンスペースのシャドウマップについて詳しく見ていきます。

Shadows.CollectShaadowsパスはデプステクスチャからワールド座標を復元して それをシャドウマップと比較することで影かどうかを判定する処理になっています。

デプステクスチャはレンダリングパスの最初で作られています。 Shadow Casterでバイアスをすべて0にしてdepthをレンダリングしています。

Shadow Casterパスを用意しないと影を受け取る計算の方も正しくできないことになります。

フレームデバッガによるとShadows.CollectShadowsは Hidden/Internal-ScreenSpaceShadowsというシェーダが使われています。

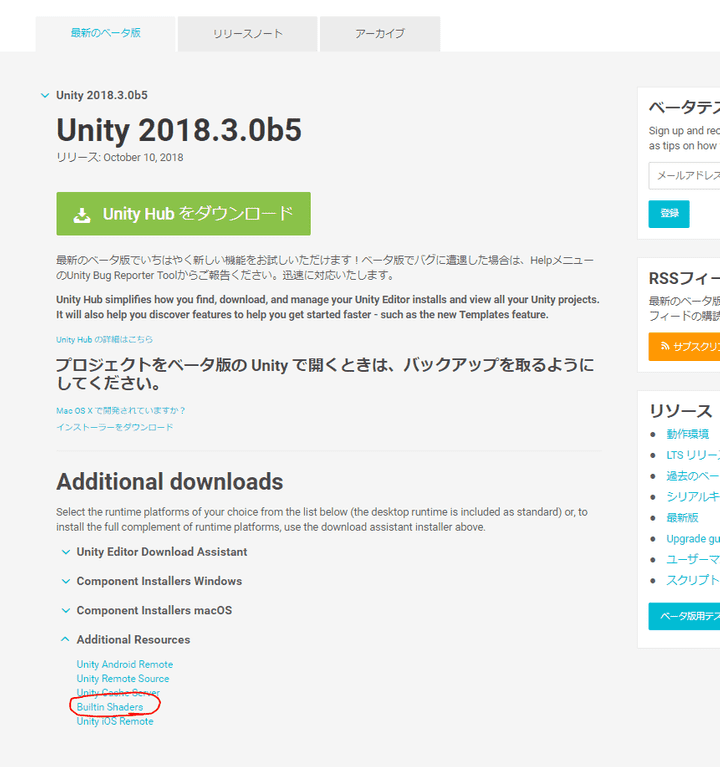

次のページからビルトインシェーダをダウンロードして確認してみます。

DefaultResourcesExtra/内にInternal-ScreenSpaceShadows.shaderがあります。

ちょっと長いですが全文貼ります。

// Unity built-in shader source. Copyright (c) 2016 Unity Technologies. MIT license (see license.txt)

// Collects cascaded shadows into screen space buffer

Shader "Hidden/Internal-ScreenSpaceShadows" {

Properties {

_ShadowMapTexture ("", any) = "" {}

_ODSWorldTexture("", 2D) = "" {}

}

CGINCLUDE

UNITY_DECLARE_SHADOWMAP(_ShadowMapTexture);

float4 _ShadowMapTexture_TexelSize;

#define SHADOWMAPSAMPLER_AND_TEXELSIZE_DEFINED

sampler2D _ODSWorldTexture;

#include "UnityCG.cginc"

#include "UnityShadowLibrary.cginc"

// Configuration

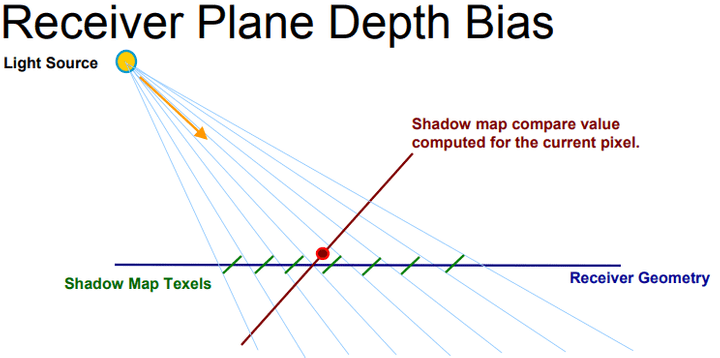

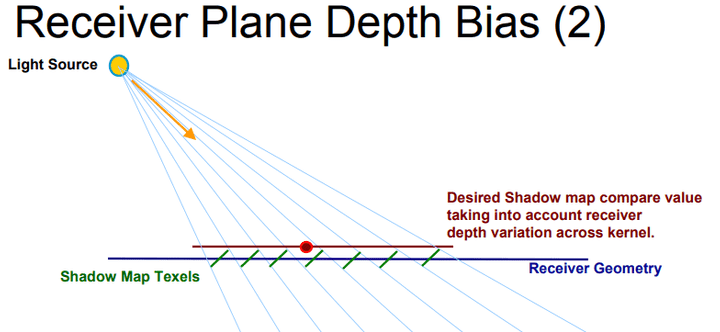

// Should receiver plane bias be used? This estimates receiver slope using derivatives,

// and tries to tilt the PCF kernel along it. However, since we're doing it in screenspace

// from the depth texture, the derivatives are wrong on edges or intersections of objects,

// leading to possible shadow artifacts. So it's disabled by default.

// See also UnityGetReceiverPlaneDepthBias in UnityShadowLibrary.cginc.

//#define UNITY_USE_RECEIVER_PLANE_BIAS

// Blend between shadow cascades to hide the transition seams?

#define UNITY_USE_CASCADE_BLENDING 0

#define UNITY_CASCADE_BLEND_DISTANCE 0.1

struct appdata {

float4 vertex : POSITION;

float2 texcoord : TEXCOORD0;

#ifdef UNITY_STEREO_INSTANCING_ENABLED

float3 ray0 : TEXCOORD1;

float3 ray1 : TEXCOORD2;

#else

float3 ray : TEXCOORD1;

#endif

UNITY_VERTEX_INPUT_INSTANCE_ID

};

struct v2f {

float4 pos : SV_POSITION;

// xy uv / zw screenpos

float4 uv : TEXCOORD0;

// View space ray, for perspective case

float3 ray : TEXCOORD1;

// Orthographic view space positions (need xy as well for oblique matrices)

float3 orthoPosNear : TEXCOORD2;

float3 orthoPosFar : TEXCOORD3;

UNITY_VERTEX_INPUT_INSTANCE_ID

UNITY_VERTEX_OUTPUT_STEREO

};

v2f vert (appdata v)

{

v2f o;

UNITY_SETUP_INSTANCE_ID(v);

UNITY_TRANSFER_INSTANCE_ID(v, o);

UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO(o);

float4 clipPos;

#if defined(STEREO_CUBEMAP_RENDER_ON)

clipPos = mul(UNITY_MATRIX_VP, mul(unity_ObjectToWorld, v.vertex));

#else

clipPos = UnityObjectToClipPos(v.vertex);

#endif

o.pos = clipPos;

o.uv.xy = v.texcoord;

// unity_CameraInvProjection at the PS level.

o.uv.zw = ComputeNonStereoScreenPos(clipPos);

// Perspective case

#ifdef UNITY_STEREO_INSTANCING_ENABLED

o.ray = unity_StereoEyeIndex == 0 ? v.ray0 : v.ray1;

#else

o.ray = v.ray;

#endif

// To compute view space position from Z buffer for orthographic case,

// we need different code than for perspective case. We want to avoid

// doing matrix multiply in the pixel shader: less operations, and less

// constant registers used. Particularly with constant registers, having

// unity_CameraInvProjection in the pixel shader would push the PS over SM2.0

// limits.

clipPos.y *= _ProjectionParams.x;

float3 orthoPosNear = mul(unity_CameraInvProjection, float4(clipPos.x,clipPos.y,-1,1)).xyz;

float3 orthoPosFar = mul(unity_CameraInvProjection, float4(clipPos.x,clipPos.y, 1,1)).xyz;

orthoPosNear.z *= -1;

orthoPosFar.z *= -1;

o.orthoPosNear = orthoPosNear;

o.orthoPosFar = orthoPosFar;

return o;

}

// ------------------------------------------------------------------

// Helpers

// ------------------------------------------------------------------

UNITY_DECLARE_DEPTH_TEXTURE(_CameraDepthTexture);

// sizes of cascade projections, relative to first one

float4 unity_ShadowCascadeScales;

//

// Keywords based defines

//

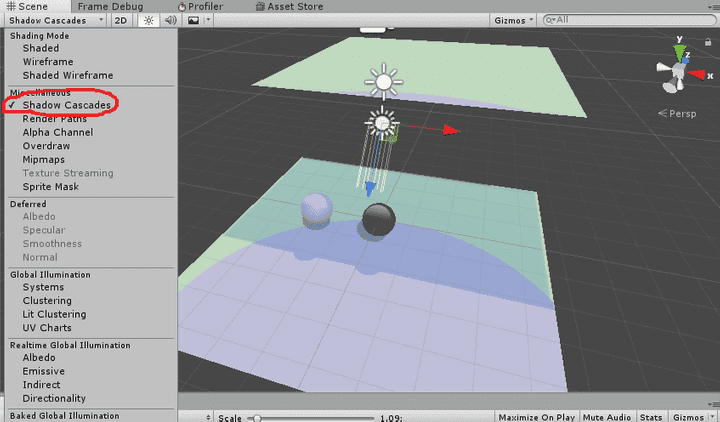

#if defined (SHADOWS_SPLIT_SPHERES)

#define GET_CASCADE_WEIGHTS(wpos, z) getCascadeWeights_splitSpheres(wpos)

#else

#define GET_CASCADE_WEIGHTS(wpos, z) getCascadeWeights( wpos, z )

#endif

#if defined (SHADOWS_SINGLE_CASCADE)

#define GET_SHADOW_COORDINATES(wpos,cascadeWeights) getShadowCoord_SingleCascade(wpos)

#else

#define GET_SHADOW_COORDINATES(wpos,cascadeWeights) getShadowCoord(wpos,cascadeWeights)

#endif

/**

* Gets the cascade weights based on the world position of the fragment.

* Returns a float4 with only one component set that corresponds to the appropriate cascade.

*/

inline fixed4 getCascadeWeights(float3 wpos, float z)

{

fixed4 zNear = float4( z >= _LightSplitsNear );

fixed4 zFar = float4( z < _LightSplitsFar );

fixed4 weights = zNear * zFar;

return weights;

}

/**

* Gets the cascade weights based on the world position of the fragment and the poisitions of the split spheres for each cascade.

* Returns a float4 with only one component set that corresponds to the appropriate cascade.

*/

inline fixed4 getCascadeWeights_splitSpheres(float3 wpos)

{

float3 fromCenter0 = wpos.xyz - unity_ShadowSplitSpheres[0].xyz;

float3 fromCenter1 = wpos.xyz - unity_ShadowSplitSpheres[1].xyz;

float3 fromCenter2 = wpos.xyz - unity_ShadowSplitSpheres[2].xyz;

float3 fromCenter3 = wpos.xyz - unity_ShadowSplitSpheres[3].xyz;

float4 distances2 = float4(dot(fromCenter0,fromCenter0), dot(fromCenter1,fromCenter1), dot(fromCenter2,fromCenter2), dot(fromCenter3,fromCenter3));

fixed4 weights = float4(distances2 < unity_ShadowSplitSqRadii);

weights.yzw = saturate(weights.yzw - weights.xyz);

return weights;

}

/**

* Returns the shadowmap coordinates for the given fragment based on the world position and z-depth.

* These coordinates belong to the shadowmap atlas that contains the maps for all cascades.

*/

inline float4 getShadowCoord( float4 wpos, fixed4 cascadeWeights )

{

float3 sc0 = mul (unity_WorldToShadow[0], wpos).xyz;

float3 sc1 = mul (unity_WorldToShadow[1], wpos).xyz;

float3 sc2 = mul (unity_WorldToShadow[2], wpos).xyz;

float3 sc3 = mul (unity_WorldToShadow[3], wpos).xyz;

float4 shadowMapCoordinate = float4(sc0 * cascadeWeights[0] + sc1 * cascadeWeights[1] + sc2 * cascadeWeights[2] + sc3 * cascadeWeights[3], 1);

#if defined(UNITY_REVERSED_Z)

float noCascadeWeights = 1 - dot(cascadeWeights, float4(1, 1, 1, 1));

shadowMapCoordinate.z += noCascadeWeights;

#endif

return shadowMapCoordinate;

}

/**

* Same as the getShadowCoord; but optimized for single cascade

*/

inline float4 getShadowCoord_SingleCascade( float4 wpos )

{

return float4( mul (unity_WorldToShadow[0], wpos).xyz, 0);

}

/**

* Get camera space coord from depth and inv projection matrices

*/

inline float3 computeCameraSpacePosFromDepthAndInvProjMat(v2f i)

{

float zdepth = SAMPLE_DEPTH_TEXTURE(_CameraDepthTexture, i.uv.xy);

#if defined(UNITY_REVERSED_Z)

zdepth = 1 - zdepth;

#endif

// View position calculation for oblique clipped projection case.

// this will not be as precise nor as fast as the other method

// (which computes it from interpolated ray & depth) but will work

// with funky projections.

float4 clipPos = float4(i.uv.zw, zdepth, 1.0);

clipPos.xyz = 2.0f * clipPos.xyz - 1.0f;

float4 camPos = mul(unity_CameraInvProjection, clipPos);

camPos.xyz /= camPos.w;

camPos.z *= -1;

return camPos.xyz;

}

/**

* Get camera space coord from depth and info from VS

*/

inline float3 computeCameraSpacePosFromDepthAndVSInfo(v2f i)

{

float zdepth = SAMPLE_DEPTH_TEXTURE(_CameraDepthTexture, i.uv.xy);

// 0..1 linear depth, 0 at camera, 1 at far plane.

float depth = lerp(Linear01Depth(zdepth), zdepth, unity_OrthoParams.w);

#if defined(UNITY_REVERSED_Z)

zdepth = 1 - zdepth;

#endif

// view position calculation for perspective & ortho cases

float3 vposPersp = i.ray * depth;

float3 vposOrtho = lerp(i.orthoPosNear, i.orthoPosFar, zdepth);

// pick the perspective or ortho position as needed

float3 camPos = lerp(vposPersp, vposOrtho, unity_OrthoParams.w);

return camPos.xyz;

}

inline float3 computeCameraSpacePosFromDepth(v2f i);

/**

* Hard shadow

*/

fixed4 frag_hard (v2f i) : SV_Target

{

UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX(i); // required for sampling the correct slice of the shadow map render texture array

float4 wpos;

float3 vpos;

#if defined(STEREO_CUBEMAP_RENDER_ON)

wpos.xyz = tex2D(_ODSWorldTexture, i.uv.xy).xyz;

wpos.w = 1.0f;

vpos = mul(unity_WorldToCamera, wpos).xyz;

#else

vpos = computeCameraSpacePosFromDepth(i);

wpos = mul (unity_CameraToWorld, float4(vpos,1));

#endif

fixed4 cascadeWeights = GET_CASCADE_WEIGHTS (wpos, vpos.z);

float4 shadowCoord = GET_SHADOW_COORDINATES(wpos, cascadeWeights);

//1 tap hard shadow

fixed shadow = UNITY_SAMPLE_SHADOW(_ShadowMapTexture, shadowCoord);

shadow = lerp(_LightShadowData.r, 1.0, shadow);

fixed4 res = shadow;

return res;

}

/**

* Soft Shadow (SM 3.0)

*/

fixed4 frag_pcfSoft(v2f i) : SV_Target

{

UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX(i); // required for sampling the correct slice of the shadow map render texture array

float4 wpos;

float3 vpos;

#if defined(STEREO_CUBEMAP_RENDER_ON)

wpos.xyz = tex2D(_ODSWorldTexture, i.uv.xy).xyz;

wpos.w = 1.0f;

vpos = mul(unity_WorldToCamera, wpos).xyz;

#else

vpos = computeCameraSpacePosFromDepth(i);

// sample the cascade the pixel belongs to

wpos = mul(unity_CameraToWorld, float4(vpos,1));

#endif

fixed4 cascadeWeights = GET_CASCADE_WEIGHTS(wpos, vpos.z);

float4 coord = GET_SHADOW_COORDINATES(wpos, cascadeWeights);

float3 receiverPlaneDepthBias = 0.0;

#ifdef UNITY_USE_RECEIVER_PLANE_BIAS

// Reveiver plane depth bias: need to calculate it based on shadow coordinate

// as it would be in first cascade; otherwise derivatives

// at cascade boundaries will be all wrong. So compute

// it from cascade 0 UV, and scale based on which cascade we're in.

float3 coordCascade0 = getShadowCoord_SingleCascade(wpos);

float biasMultiply = dot(cascadeWeights,unity_ShadowCascadeScales);

receiverPlaneDepthBias = UnityGetReceiverPlaneDepthBias(coordCascade0.xyz, biasMultiply);

#endif

#if defined(SHADER_API_MOBILE)

half shadow = UnitySampleShadowmap_PCF5x5(coord, receiverPlaneDepthBias);

#else

half shadow = UnitySampleShadowmap_PCF7x7(coord, receiverPlaneDepthBias);

#endif

shadow = lerp(_LightShadowData.r, 1.0f, shadow);

// Blend between shadow cascades if enabled

//

// Not working yet with split spheres, and no need when 1 cascade

#if UNITY_USE_CASCADE_BLENDING && !defined(SHADOWS_SPLIT_SPHERES) && !defined(SHADOWS_SINGLE_CASCADE)

half4 z4 = (float4(vpos.z,vpos.z,vpos.z,vpos.z) - _LightSplitsNear) / (_LightSplitsFar - _LightSplitsNear);

half alpha = dot(z4 * cascadeWeights, half4(1,1,1,1));

UNITY_BRANCH

if (alpha > 1 - UNITY_CASCADE_BLEND_DISTANCE)

{

// get alpha to 0..1 range over the blend distance

alpha = (alpha - (1 - UNITY_CASCADE_BLEND_DISTANCE)) / UNITY_CASCADE_BLEND_DISTANCE;

// sample next cascade

cascadeWeights = fixed4(0, cascadeWeights.xyz);

coord = GET_SHADOW_COORDINATES(wpos, cascadeWeights);

#ifdef UNITY_USE_RECEIVER_PLANE_BIAS

biasMultiply = dot(cascadeWeights,unity_ShadowCascadeScales);

receiverPlaneDepthBias = UnityGetReceiverPlaneDepthBias(coordCascade0.xyz, biasMultiply);

#endif

half shadowNextCascade = UnitySampleShadowmap_PCF3x3(coord, receiverPlaneDepthBias);

shadowNextCascade = lerp(_LightShadowData.r, 1.0f, shadowNextCascade);

shadow = lerp(shadow, shadowNextCascade, alpha);

}

#endif

return shadow;

}

ENDCG

// ----------------------------------------------------------------------------------------

// Subshader for hard shadows:

// Just collect shadows into the buffer. Used on pre-SM3 GPUs and when hard shadows are picked.

SubShader {

Tags{ "ShadowmapFilter" = "HardShadow" }

Pass {

ZWrite Off ZTest Always Cull Off

CGPROGRAM

#pragma vertex vert

#pragma fragment frag_hard

#pragma multi_compile_shadowcollector

inline float3 computeCameraSpacePosFromDepth(v2f i)

{

return computeCameraSpacePosFromDepthAndVSInfo(i);

}

ENDCG

}

}

// ----------------------------------------------------------------------------------------

// Subshader for hard shadows:

// Just collect shadows into the buffer. Used on pre-SM3 GPUs and when hard shadows are picked.

// This version does inv projection at the PS level, slower and less precise however more general.

SubShader {

Tags{ "ShadowmapFilter" = "HardShadow_FORCE_INV_PROJECTION_IN_PS" }

Pass{

ZWrite Off ZTest Always Cull Off

CGPROGRAM

#pragma vertex vert

#pragma fragment frag_hard

#pragma multi_compile_shadowcollector

inline float3 computeCameraSpacePosFromDepth(v2f i)

{

return computeCameraSpacePosFromDepthAndInvProjMat(i);

}

ENDCG

}

}

// ----------------------------------------------------------------------------------------

// Subshader that does soft PCF filtering while collecting shadows.

// Requires SM3 GPU.

Subshader {

Tags {"ShadowmapFilter" = "PCF_SOFT"}

Pass {

ZWrite Off ZTest Always Cull Off

CGPROGRAM

#pragma vertex vert

#pragma fragment frag_pcfSoft

#pragma multi_compile_shadowcollector

#pragma target 3.0

inline float3 computeCameraSpacePosFromDepth(v2f i)

{

return computeCameraSpacePosFromDepthAndVSInfo(i);

}

ENDCG

}

}

// ----------------------------------------------------------------------------------------

// Subshader that does soft PCF filtering while collecting shadows.

// Requires SM3 GPU.

// This version does inv projection at the PS level, slower and less precise however more general.

Subshader{

Tags{ "ShadowmapFilter" = "PCF_SOFT_FORCE_INV_PROJECTION_IN_PS" }

Pass{

ZWrite Off ZTest Always Cull Off

CGPROGRAM

#pragma vertex vert

#pragma fragment frag_pcfSoft

#pragma multi_compile_shadowcollector

#pragma target 3.0

inline float3 computeCameraSpacePosFromDepth(v2f i)

{

return computeCameraSpacePosFromDepthAndInvProjMat(i);

}

ENDCG

}

}

Fallback Off

}最後の4つのSubshaderが本体です。

ソフトな影かハードな影かによってフラグメントシェーダが異なっています。

そしてフラグメントシェーダで呼ばれるcomputeCameraSpacePosFromDepthの実態が

computeCameraSpacePosFromDepthAndVSInfoと

computeCameraSpacePosFromDepthAndInvProjMatの2つ用意されています。

computeCameraSpacePosFromDepthはprojectionがperspectiveやorthographicなどの

単純な場合に利用される軽量な方法です。

computeCameraSpacePosFromDepthAndInvProjMatはprojectionが

特殊な行列の場合に利用される方法です。

最初に頂点シェーダの入力を見てみます。

struct appdata {

float4 vertex : POSITION;

float2 texcoord : TEXCOORD0;

#ifdef UNITY_STEREO_INSTANCING_ENABLED

float3 ray0 : TEXCOORD1;

float3 ray1 : TEXCOORD2;

#else

float3 ray : TEXCOORD1;

#endif

UNITY_VERTEX_INPUT_INSTANCE_ID

};このScreenSpaceShadowsのパスではスクリーンを覆うquadを生成して描画するようです。 rayというのはそのquadのメッシュの頂点データとしてレイの方向が渡されるようです。

後のフラグメントシェーダでの処理を見てみると rayにはfar平面の四隅へのベクトルが渡されるようです。

UNITY_STEREO_INSTANCING_ENABLEDで分岐しているのはVR向けの場合に

インスタンシングで描画しているとかそういうのだと思います。

以降もインスタンシングの有無で分岐している箇所が多々あります。

次にv2f構造体を見てみます。

struct v2f {

float4 pos : SV_POSITION;

// xy uv / zw screenpos

float4 uv : TEXCOORD0;

// View space ray, for perspective case

float3 ray : TEXCOORD1;

// Orthographic view space positions (need xy as well for oblique matrices)

float3 orthoPosNear : TEXCOORD2;

float3 orthoPosFar : TEXCOORD3;

UNITY_VERTEX_INPUT_INSTANCE_ID

UNITY_VERTEX_OUTPUT_STEREO

};書かれているとおりです。

次に頂点シェーダを見てみます。

v2f vert (appdata v)

{

v2f o;

UNITY_SETUP_INSTANCE_ID(v);

UNITY_TRANSFER_INSTANCE_ID(v, o);